AutoGen:通过多Agent对话实现下一代LLM应用

定制化、对话式、多Agent协作的智能应用框架

直达下载

返回上一页

描述

AutoGen是一个框架,通过多Agent对话实现下一代LLM(Large Language Model)应用的开发。它支持定制化、对话式、多Agent协作的智能应用,提供了强大的LLM推理功能,包括缓存、错误处理、多配置推理和模板化,使得开发者能够轻松构建复杂的对话式应用。

介绍

AutoGen是一个框架,通过多Agent对话实现下一代LLM(Large Language Model)应用的开发。它支持定制化、对话式、多Agent协作的智能应用,提供了强大的LLM推理功能,包括缓存、错误处理、多配置推理和模板化,使得开发者能够轻松构建复杂的对话式应用。

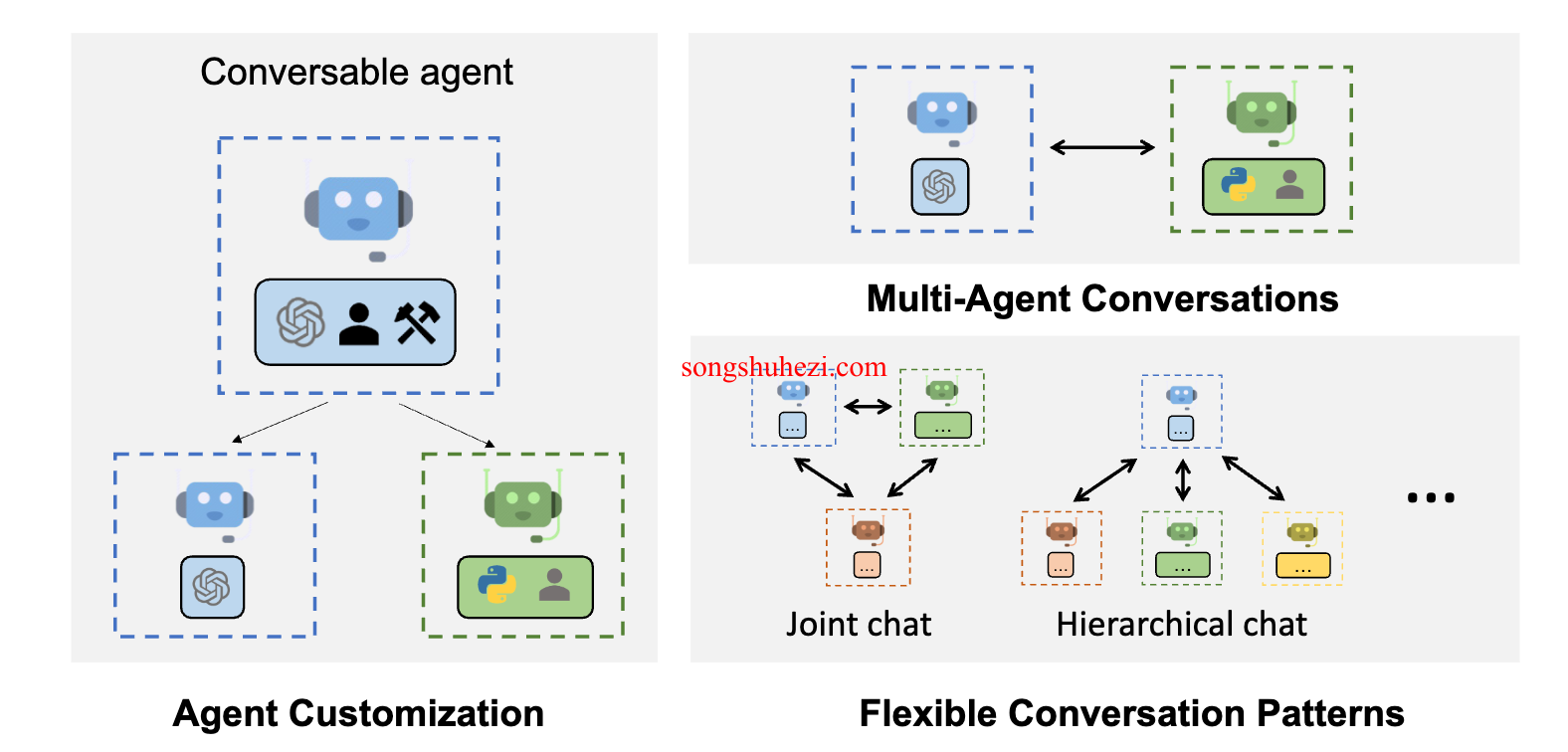

AutoGen的多Agent对话框架具有以下特点:

- 多Agent对话:AutoGen代理可以相互通信以解决任务。这使得应用能够比单个LLM更加复杂和复杂。

- 定制化:AutoGen代理可以根据应用的特定需求进行定制。这包括选择要使用的LLM、允许的人类输入类型以及要使用的工具。

- 人类参与:AutoGen可以无缝地允许人类参与。这意味着人类可以根据需要向代理提供输入和反馈。

例如,以下是一个示例代码:

from autogen import AssistantAgent, UserProxyAgent, config_list_from_json

# 从环境变量或文件中加载LLM推理端点

config_list = config_list_from_json(env_or_file="OAI_CONFIG_LIST")

# 创建AutoGen代理

assistant = AssistantAgent("assistant", llm_config={"config_list": config_list})

user_proxy = UserProxyAgent("user_proxy", code_execution_config={"work_dir": "coding", "use_docker": False})

# 启动对话

user_proxy.initiate_chat(assistant, message="Plot a chart of NVDA and TESLA stock price change YTD.")

该示例演示了如何启动两个AutoGen代理之间的对话以解决任务。

此外,AutoGen还提供了一个示例代码,允许用户与一个AutoGen代理进行ChatGPT风格的对话。

Enhanced LLM Inferences

AutoGen还帮助最大化利用昂贵的LLM,如ChatGPT和GPT-4。它提供了增强的LLM推理功能,包括缓存、错误处理、多配置推理和模板化。

×

直达下载

×

初次访问:反爬虫,人机识别