VSP-LLM框架:高效的视觉语音处理

更准确、更自然的视觉语音识别和翻译

直达下载

返回上一页

描述

VSP-LLM框架——高效的视觉语音处理新方向

介绍

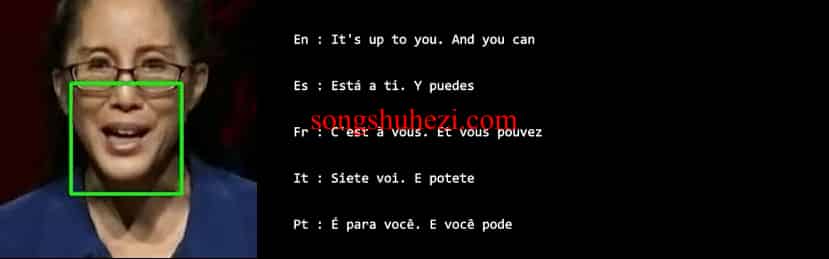

引入了一种全新的框架——VSP-LLM(Visual Speech Processing incorporated with LLMs),即结合LLMs的视觉语言处理,这一框架通过引入大型语言模型(LLMs)的强大能力,极大地提升了上下文建模的能力。VSP-LLM旨在执行视觉语音识别和翻译的多任务,通过自监督的视觉语言模型将输入视频映射到LLM的输入潜空间。

针对输入帧中冗余信息问题,我们提出了一种新颖的去重方法,通过视觉语言单元减少嵌入式视觉特征。通过所提出的去重方法和低秩适配器(LoRA),VSP-LLM可以以计算高效的方式进行训练。

准备工作

环境搭建: 首先创建并激活名为vsp-llm的Python 3.9环境。

conda create -n vsp-llm python=3.9 -y conda activate vsp-llm代码获取: 克隆VSP-LLM项目到本地,并安装必要的依赖包。

git clone https://github.com/Sally-SH/VSP-LLM.git cd VSP-LLM pip install -r requirements.txt模型与数据准备:下载AV-HuBERT预训练模型和LLaMA2-7B模型,以及根据Auto-AVSR准备LRS3数据集。

数据预处理

- 根据Auto-AVSR指导文档预处理LRS3数据集。

- 遵循AV-HuBERT的步骤从第3步开始创建LRS3数据集的清单。

训练流程

脚本配置:在训练脚本(scripts/train.sh)中替换相应的变量路径。

执行训练: 运行训练脚本,开始模型的训练过程。

bash scripts/train.sh

解码与评估

在解码脚本(scripts/decode.sh)中配置相应的变量路径。

执行解码脚本,得到模型的解码结果和评分。

bash scripts/decode.sh

VSP-LLM框架为视觉语音处理领域带来了一次质的飞跃,通过高效的去重方法和LLMs的强大上下文建模能力,实现了更准确、更自然的视觉语音识别和翻译。无论是研究者还是技术爱好者,VSP-LLM都开启了探索视觉语音处理新方法的大门。

×

直达下载

×

初次访问:反爬虫,人机识别