MCP协议的Streamable HTTP传输层解决了什么?

你知道吗?在用AI工具的时候,如果网络一断,那些正在跑的任务,比如长文档分析、聊天记录生成啥的,有时候就全白搭了——这可真让人抓狂。为了解决这些“崩溃时刻”,MCP 协议最近出了一个新功能,叫做 Streamable HTTP,对,就是一个全新的传输机制。

说白了,就是帮AI模型和外部工具之间建立一个更稳定、更灵活、更节能的“通话管道”。之前用的 HTTP + SSE(服务器发送事件)方案虽然也不错,但遇到网络不稳定、高并发或者大规模部署时,问题就来了。现在 MCP 官方给它换上了一个“聪明”的传输层,真的体验上来了!

原来的 HTTP + SSE 是咋回事?

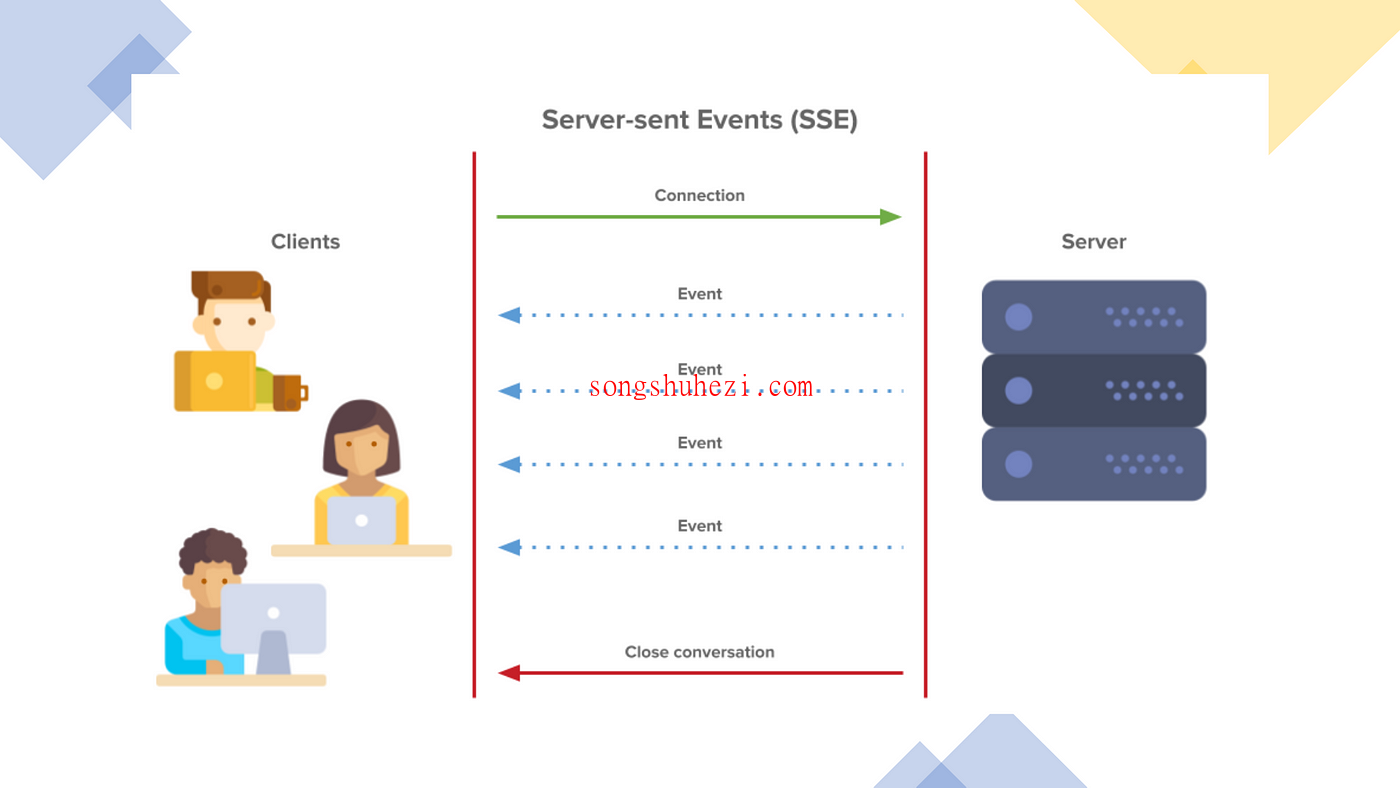

之前 MCP 的传输模式,其实是两个通道在工作:

- HTTP请求发消息:模型通过POST把消息发到服务器

- SSE通道接收回应:服务器用SSE把回应“推送”回来

这套逻辑其实简单直接,但也有点“老了”,主要是这些问题太真实了:

- 断了就重来:一旦连接中断,任务全挂,模型也懵了

- 占用资源多:每个连接都得服务器“盯着看”,人多了扛不住

- 小事也走SSE:哪怕是一句“好的”,也得从SSE通道绕回来,太浪费

- 兼容性拉胯:很多CDN、负载均衡不喜欢这种长时间挂着不动的SSE

我自己在试的时候,光是“保持SSE不断线”这事就让我各种翻日志。

Streamable HTTP 上场

Streamable HTTP 是在 GitHub 的 PR #206 里提出来的,是对现有传输机制的彻底升级,它的设计理念也挺实在:

- 用现成HTTP基础设施,不用再单独跑SSE服务器

- 一套接口搞定通信、推送、流式反馈

- 支持状态保存、断线重连

- 随需应变,按需选择响应方式

是不是听起来像是传统HTTP、SSE 和 WebSocket 的结合体?它其实保留了HTTP简单易部署的优点,又解决了SSE的弱点。

那它到底是怎么工作的?

咱不说废话,直接从它的设计细节入手,讲清楚它为啥更强。

✅ 单一端点:/message

以前SSE得单独开一个 /sse,现在统一成一个 /message,GET 和 POST 都在这儿搞定。你爱怎么请求,就怎么请求,够自由。

✅ 灵活的响应方式

- 普通HTTP响应:一次请求一次回应,适合小任务

- 流式SSE响应:服务器慢慢“吐”进度和结果,适合AI生成任务

- 长连接:对话/任务长的时候,保持通话不中断

✅ 会话 ID 支持

一个“会话 ID”就像是你的身份标识,断线之后重新连接还能继续,特别适合多轮对话或者大任务中途掉线的场景。

✅ 客户端主动建连接

你还可以通过GET /message自己主动建个SSE连接,不用等服务器先推送,适合做长时间监听通知。

这都听明白了,那它能用在哪儿?

别急,这个机制是为现实场景准备的,来看看几个超实际的例子:

场景一:无状态计算服务(比如做个在线单位换算)

客户端发个POST请求,服务器马上回结果,就像传统API一样,够快够简单。

场景二:AI生成长内容(比如写一整篇报告)

请求一发,SSE流式返回进度,用户可以看到任务慢慢跑完,整个过程“有反馈”,体验非常丝滑。

场景三:多轮对话(比如做个聊天助手)

开一个会话ID,然后模型跟你边聊边流式推送回答,断线了还能续上,体验就跟打电话似的。

场景四:弱网环境(比如你在地铁上和AI互动)

断网重连不是梦,只要会话ID还在,重新GET一次 /message 就能恢复上一次的聊天进度。

开发上难不难?

我自己看了一下,这套东西其实挺好落地的。

对后端来说:

- 不需要再单独搞SSE服务

- 状态管理可以用Redis一类中间件做缓存

- GET/POST统一

/message路由就够用了 - SSE流的“格式”也不是自定义很复杂的,只要事件有个

event字段和data字段就行了

对前端或客户端来说:

- 请求构造和原来差不多,只是多了会话ID要管理

- 响应处理加一点SSE监听逻辑就搞定

- 断线重连机制也可以按你自己节奏来,加个重试逻辑就好了

总结一下 Streamable HTTP 的好处

✅ 技术上的提升:

- 跟所有 HTTP 基础设施兼容:你CDN、反向代理、Nginx啥的都不用改

- 不需要给每个连接保活,资源节省

- 支持服务水平扩展,适合上云

- 一端点搞定所有请求,结构干净

- 支持断线恢复,适合移动端、弱网场景

✅ 业务上的收益:

- 用户体验直线提升,有反馈、有连接、不卡顿

- 适配场景多,从简单API服务到复杂AI对话全都能玩

- 降低开发和维护成本,少写代码少踩坑

- 给未来扩展AI服务预留了足够的灵活性

最后

Streamable HTTP 这个功能上线之后,我是真的感觉 MCP 更“工业级”了。之前我用MCP搞多轮对话的时候,每次都得考虑SSE连不上咋办、超时咋恢复……现在基本都能靠它自动兜底。而且统一的 /message 端点也让整体项目结构清爽了不少,维护起来舒服多了。

如果你是做AI服务的、正在想怎么让模型和工具“好好说话”的,那这个协议升级你一定得了解下。它不光解决了通信上的麻烦,更是一步步把AI通信标准往成熟方向推进了。

以后再做AI助手、智能生成平台、数据分析接口,我就打算直接默认用 Streamable HTTP 做底层传输,省心省力还稳定。你要是也想体验一下“现代通信”的顺畅感,可以找个简单的项目试试,绝对值。