ComfyUI教程

ComfyUI如何使用图生图?

我们经常希望能够对生成的图像进行更细致的调控,包括调整分辨率、修改图片的具体内容或者改变图片中的某些细节。为了实现这些高级功能,我们需要深入了解 Stable Diffusion 模型的两种核心工作流:重绘和参考。接下来,我们将详细介绍如何利用这两种方法来实现更精细的图像生成控制。

前期准备

在开始之前,请确保下载并安装以下模型到 ComfyUI 的指定文件夹中:

- Dreamshaper - 放在

models/checkpoints文件夹。 - stable-diffusion-2-1-unclip - 根据需求下载 h 或 l 版本,放在同样的文件夹。

- coadapter-style-sd15v1 - 放在

models/style_models文件夹。 - OpenAI CLIP Model - 放在

models/clip_vision文件夹。

图生图的核心工作流

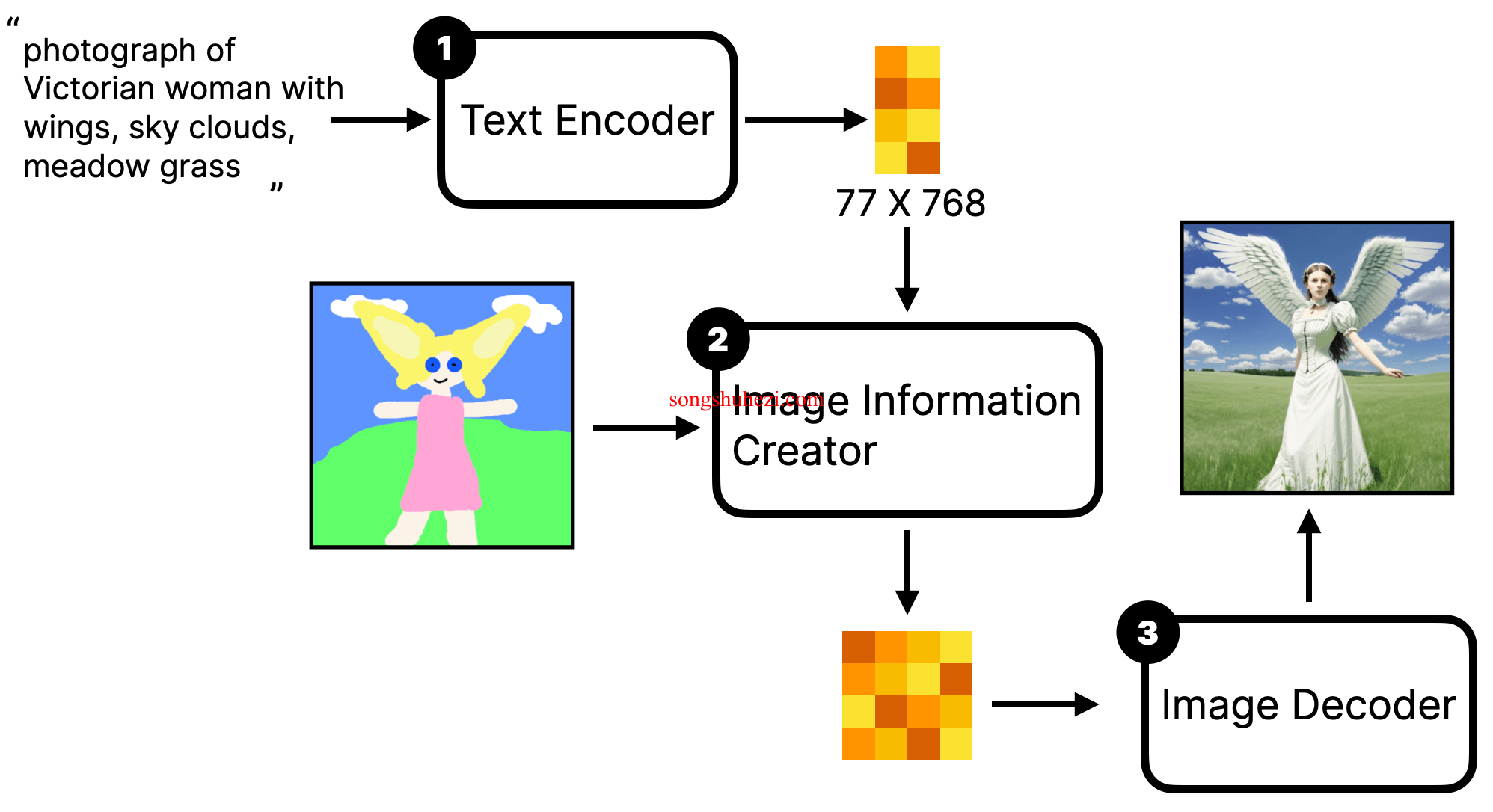

重绘工作流(Simple img2img)

这种方法通过将输入图片先添加噪声,然后再通过降噪过程生成新的图片,实际上是在原有图像的基础上进行重新创作。

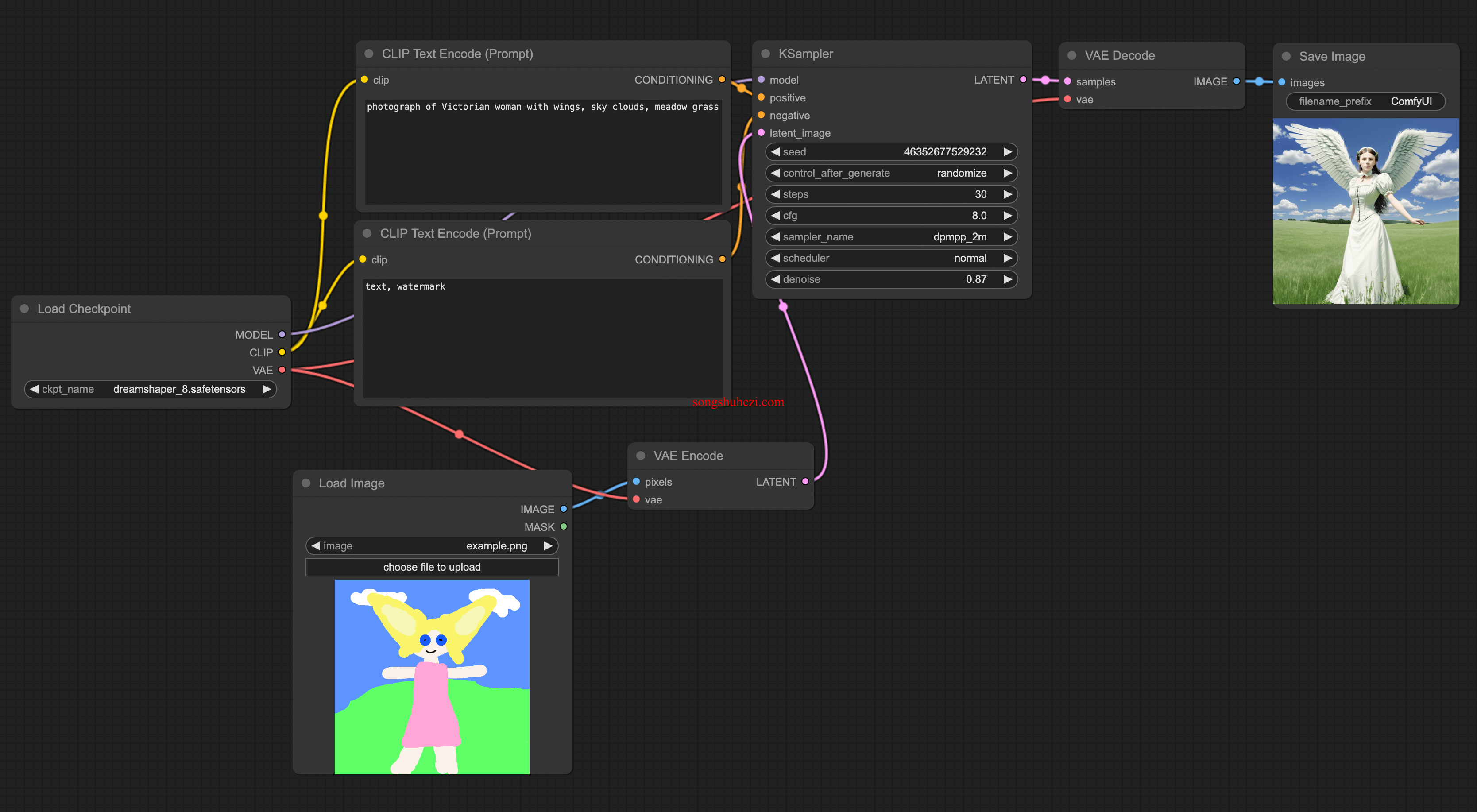

实施步骤

- 添加 Load Image 节点:从

All node → image中添加。 - 连接节点:将 Load Image 节点连接到 VAE Encode,再连接到 KSampler。

- 设置 KSampler:调整 denoise 参数以控制新生成图像与原始输入图的相似度。

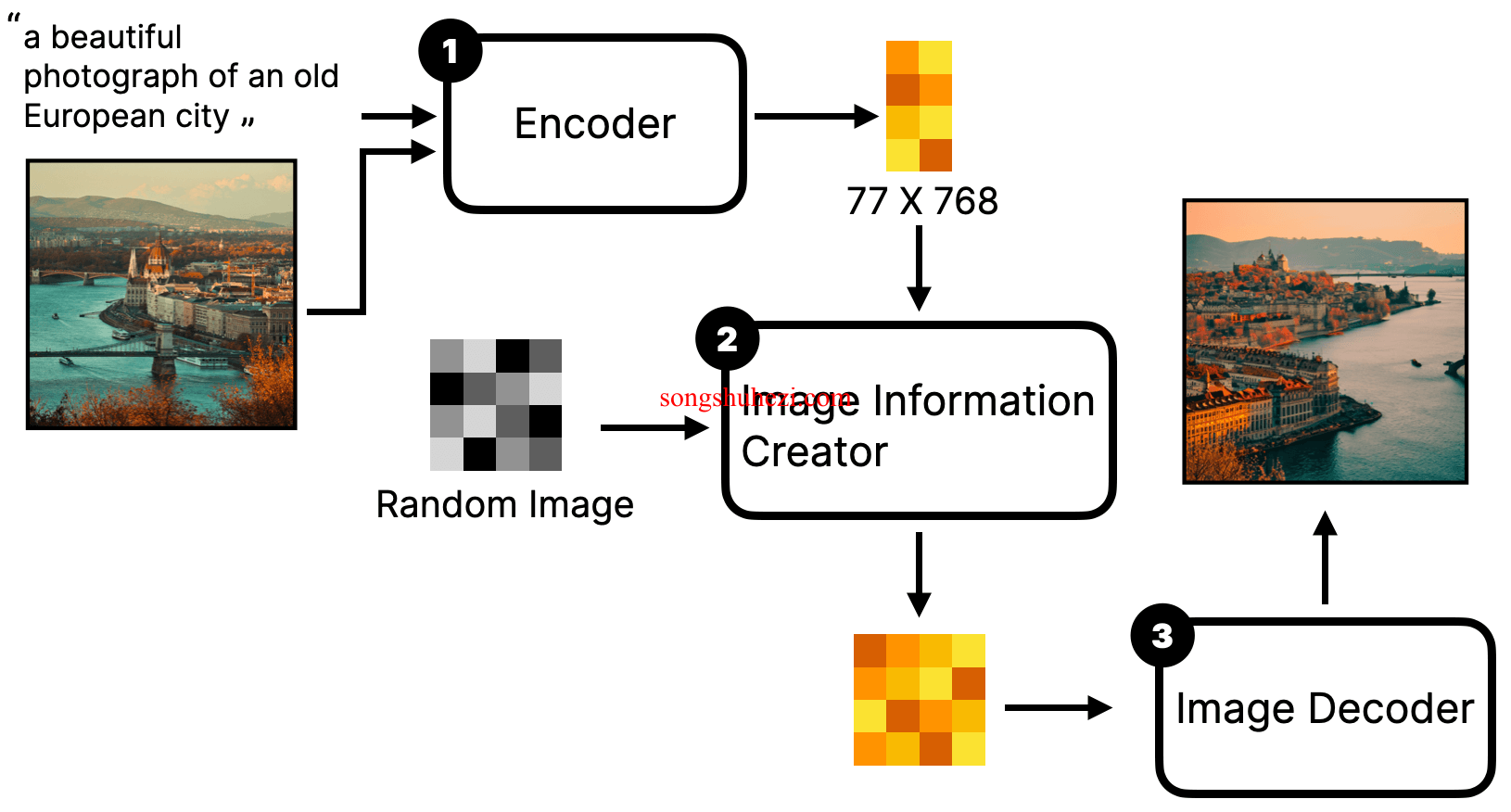

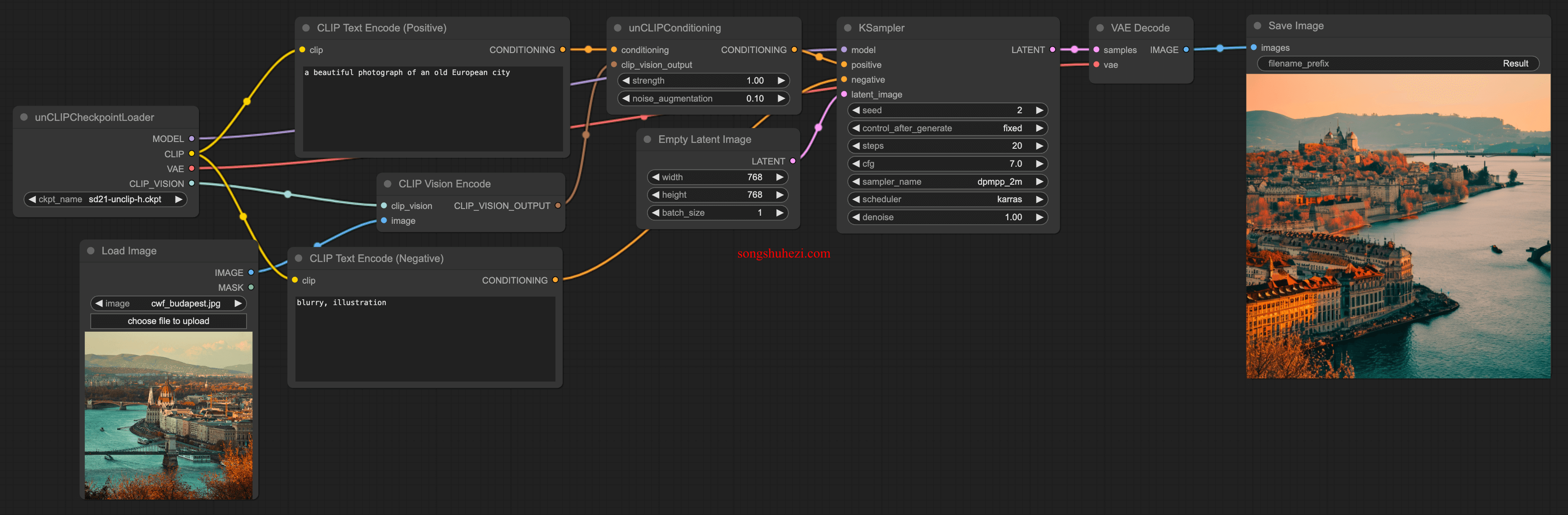

参考工作流(unCLIP model)

通过将图片作为 prompt 的一部分,与文本 prompt 一起输入模型,生成包含原图元素和风格的新图像。

实施步骤

- 添加 Load Image 和 CLIP Vision Encode 节点:从

All node → image和All node → conditioning分别添加。 - 添加 unCLIPConditioning 节点:从

All node → conditioning添加,并连接 Text Encoder 和 CLIP Vision Encode 的输出。 - 配置 unCLIPCheckpointLoader:替换默认的 Checkpoint 节点,确保模型与所用的 unCLIP 模型一致。

案例分析

简单图像到图像重绘

以下是一个使用 Dreamshaper 模型进行简单图像到图像重绘的示例,其中原始图片通过添加噪声和控制 denoise 设置被重新创作,以符合用户的新指令。

参考模型使用

使用 unCLIP model workflow 时,原始图像被作为参考素材融合到新的生成过程中,同时结合文本描述,产生含有原图元素和风格的新图像。

通过掌握和应用这两种图生图工作流,用户不仅能够提升生成图像的质量,还能在生成过程中实现更高程度的个性化控制。无论是调整图像风格,还是在生成的图像中融合具体的内容元素,这些高级技巧都将为你打开一个全新的视觉创作领域。

阅读全文

×

初次访问:反爬虫,人机识别