Ollama教程

在Docker上安装与配置Ollama

Ollama是一款开源工具,专为本地运行和管理大语言模型设计,支持多平台、多模型,操作简单,优化资源使用,保护用户隐私。

Docker作为一种轻量级的虚拟化容器技术,为运行Ollama提供了一个独立、快速的环境。如果你想在Docker中体验Ollama,这篇教程会手把手教你如何拉取镜像、运行容器以及使用常见的Ollama指令。

一、拉取Ollama镜像

在开始之前,确保你已经安装了Docker。如果还没有安装,可以前往Docker官方教程进行安装。

1.1 拉取通用镜像

打开终端,输入以下命令拉取Ollama镜像:

docker pull ollama/ollama

如果你的系统支持AMD GPU,可以使用以下命令:

docker pull ollama/ollama:rocm

1.2 拉取特定版本镜像

如果需要下载指定版本的Ollama镜像,可以在命令中添加版本号。例如:

# CPU 或 Nvidia GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0

# AMD GPU下载ollama 0.3.0

docker pull ollama/ollama:0.3.0-rocm

二、运行Ollama镜像

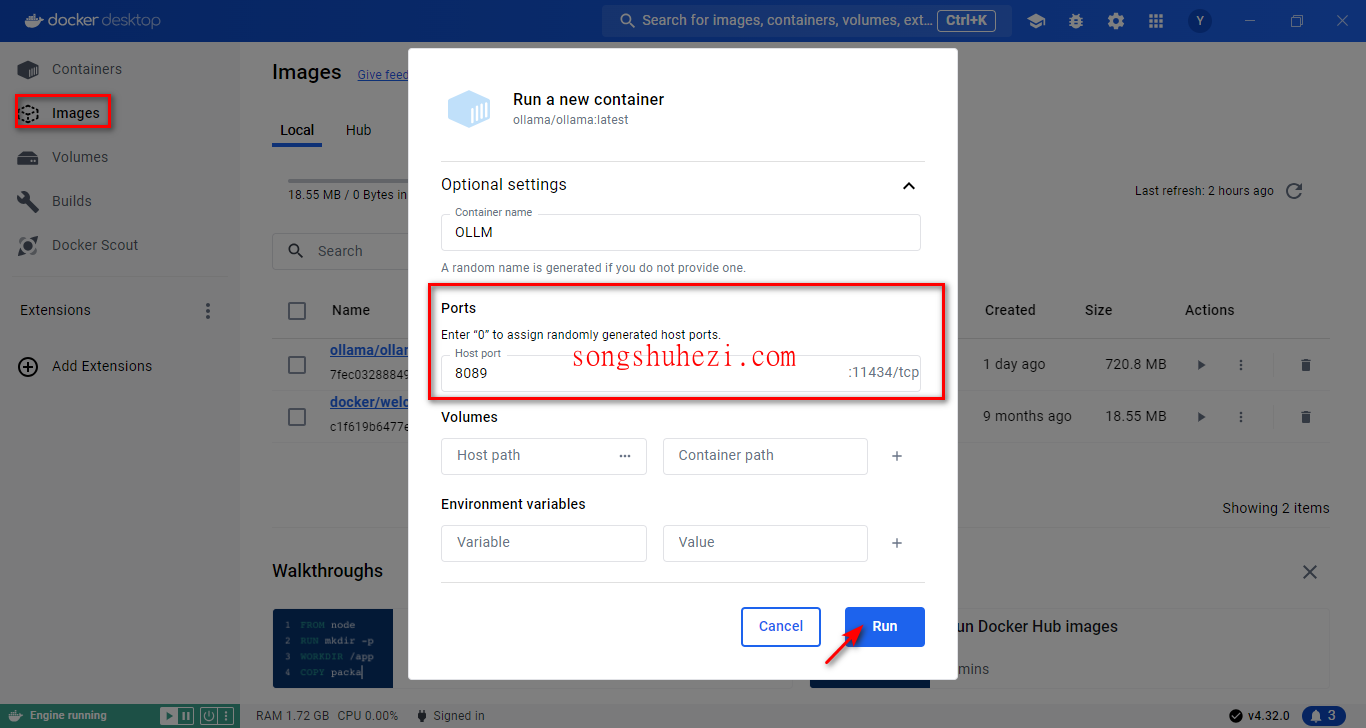

2.1 使用Docker可视化界面运行

打开Docker软件,在

Images选项卡中找到刚刚下载的Ollama镜像。

点击

Run按钮启动容器。在弹出的设置窗口中,选择一个端口号(例如8089)并保存。在

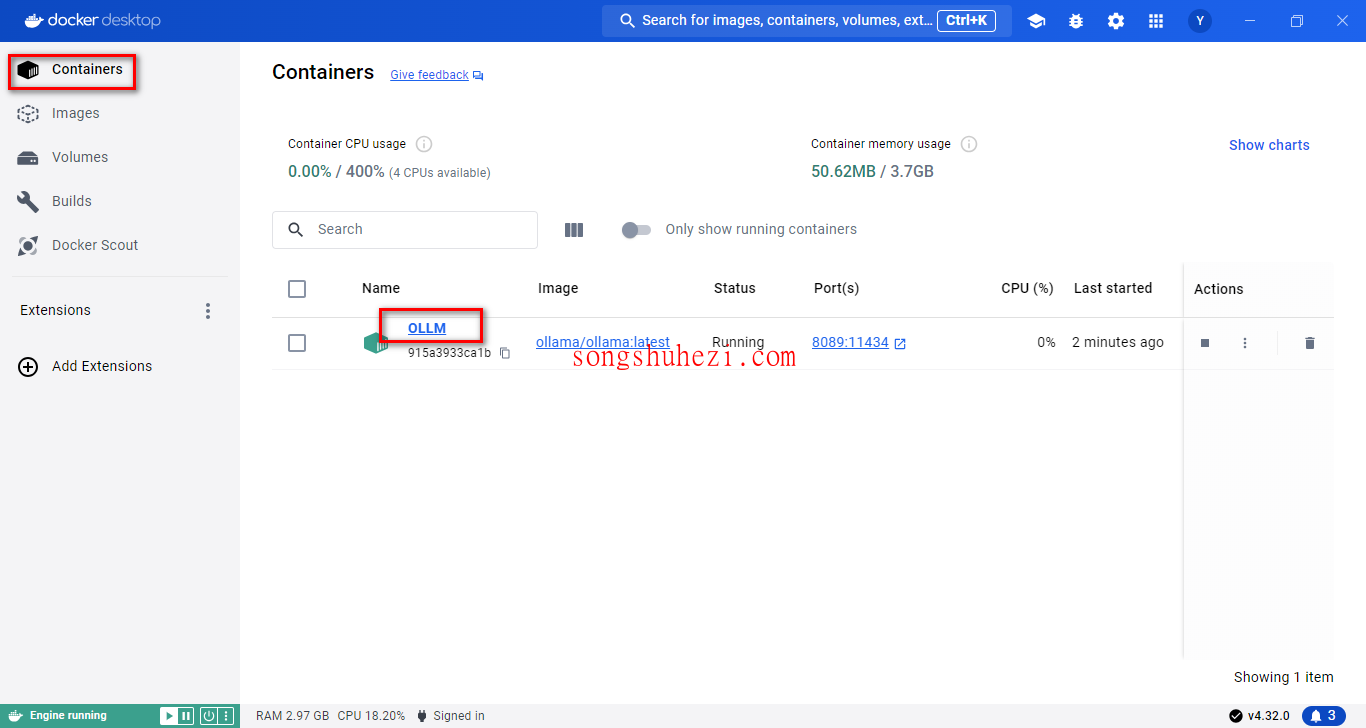

Containers选项卡中找到运行中的Ollama容器,点击进入即可。

2.2 使用命令行启动

如果你更喜欢命令行方式,可以使用以下命令启动Ollama容器:

CPU版本

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

AMD GPU版本

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama:rocm

- 参数说明:

-d:后台运行容器。-v ollama:/root/.ollama:将Ollama的配置挂载到本地。-p 11434:11434:将容器的11434端口映射到主机。--name ollama:为容器命名为ollama。

运行完成后,可以通过以下命令查看容器状态:

docker ps

三、验证安装是否成功

- 进入Ollama容器的终端:

docker exec -it ollama bash - 在容器内输入以下命令:

ollama -h - 如果输出Ollama的帮助信息,说明安装成功🎉。

四、使用Ollama常见指令

在容器内,你可以使用以下指令与Ollama交互:

ollama serve:启动Ollama服务。ollama create:从模型文件创建模型。ollama show:显示模型信息。ollama run:运行模型。ollama pull:从注册表中拉取模型。ollama push:将模型推送到注册表。ollama list:列出所有模型。ollama cp:复制模型。ollama rm:删除模型。ollama help:获取命令帮助信息。

五、运行模型示例

启动Ollama服务:

ollama serve在另一个终端中运行模型:

ollama run llama3- 模型会自动从注册表中下载,下载速度取决于你的网络带宽。

- 下载完成后即可开始与模型交互。

使用

Ctrl+D退出交互模式。

六、清理Docker容器

如果不再需要使用Ollama,可以清理Docker容器和镜像:

停止并删除容器:

docker stop ollama docker rm ollama删除镜像:

docker rmi ollama/ollama

在Docker中运行Ollama非常方便,特别是通过镜像的方式,可以快速部署一个独立的环境,避免了复杂的依赖配置。无论你是开发者还是普通用户,Docker都提供了一个高效的解决方案。如果你还没试过,不妨按照教程操作一下,感受一下Ollama的强大功能!

阅读全文

×

初次访问:反爬虫,人机识别