通过AnythingLLM+Ollama轻松实现本地AI交互界面

在日常使用AI工具的过程中,很多人都希望能够在本地实现AI模型的部署和交互,而不用依赖外部服务器。今天我们就来聊聊如何通过AnythingLLM和Ollama搭建一个本地AI交互界面。

具体来说,我们以DeepSeek为例,手把手教你如何完成安装、配置和使用。

安装Ollama

前面我写过各个系统的安装教程,大家可以看一看:

然后到Ollama的模型超市【官方链接:https://ollama.com/search】下载自己想要的模型。

比如:

如果你想要接入DeepSeek,可以看看这篇教程:

【如何通过Ollama+ChatBox安装DeepSeek本地模型】

1. 下载和安装 AnythingLLM

首先,下载AnythingLLM,这里我已经将安装包都整理到网盘了,选择适合你系统的版本进行下载。

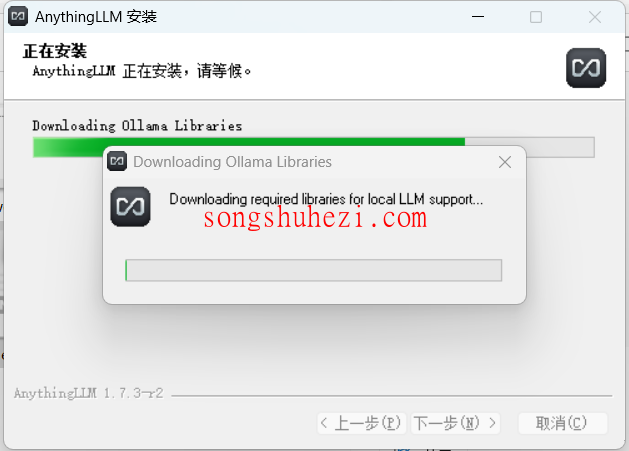

对于Windows用户,下载后直接运行安装程序,按照提示完成安装即可。安装过程中可能需要联网下载一些依赖库,确保网络畅通是关键。

对于Mac用户,则需要打开安装包,根据系统提示完成安装。如果首次运行时遇到授权提示,按照提示完成操作即可。

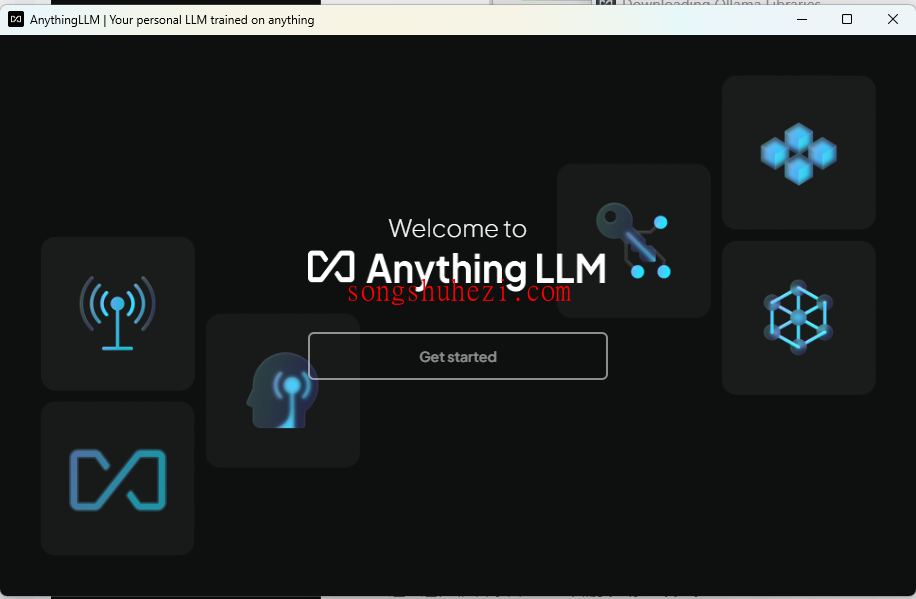

安装完成后,打开软件,你会看到一个简洁的界面。

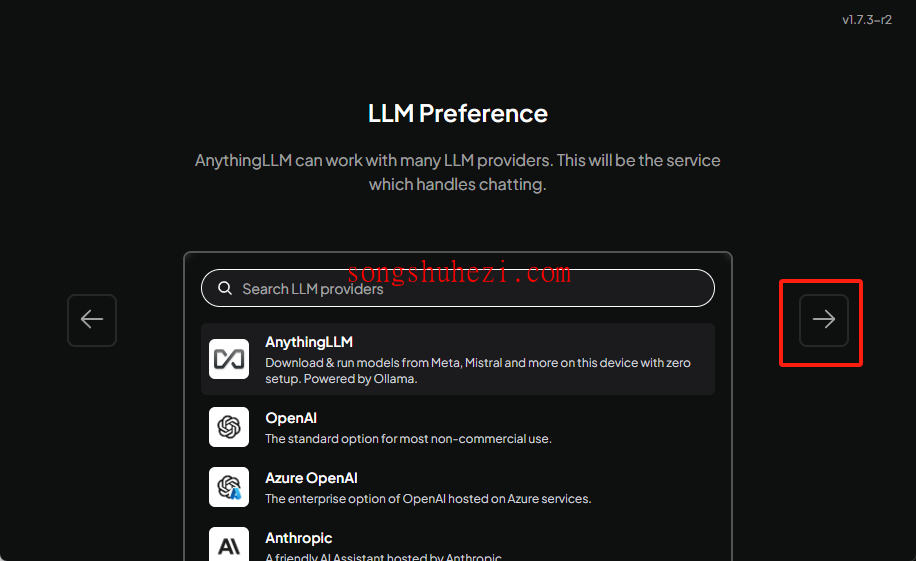

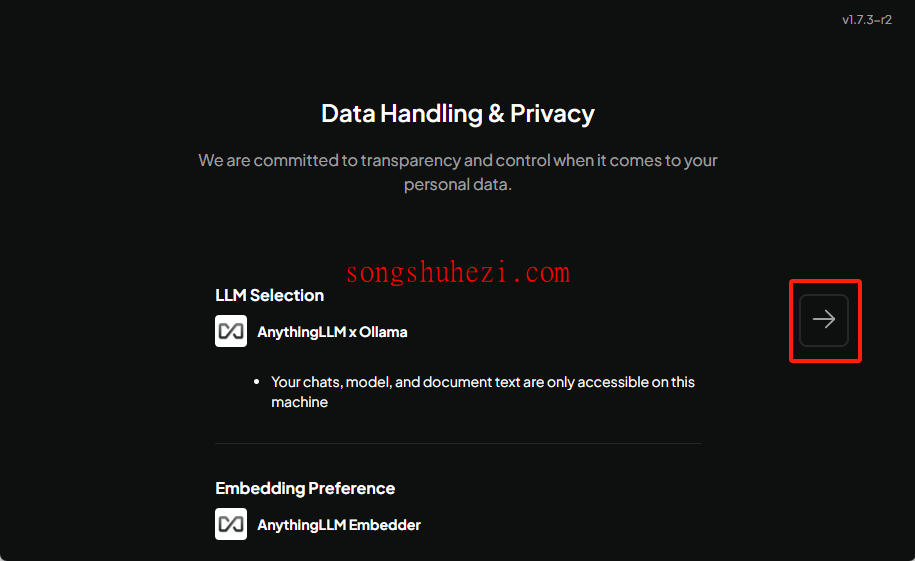

接下来只需按照界面提示点击右侧的箭头进入下一步操作。

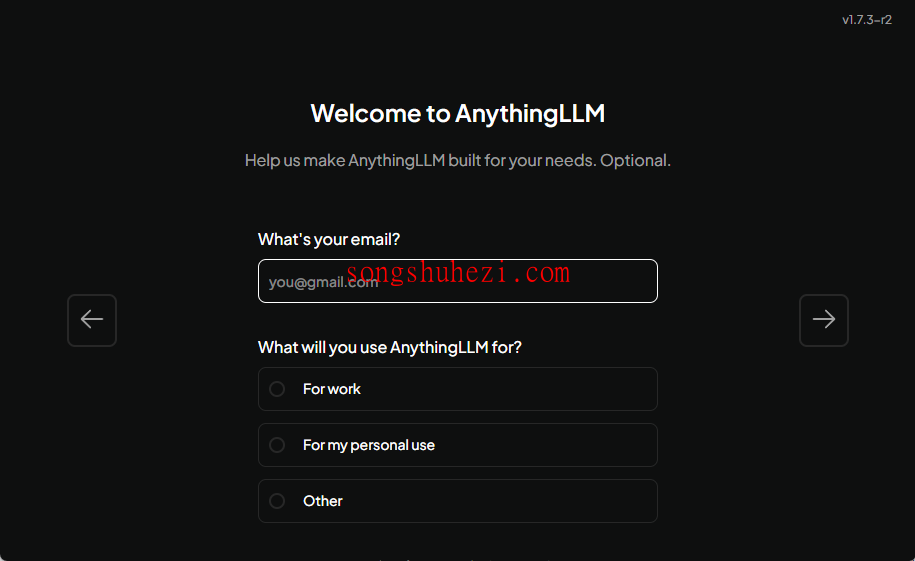

中间可能还要填一些邮箱用途之类的,按情况填写然后继续点击右侧的箭头进入下一步:

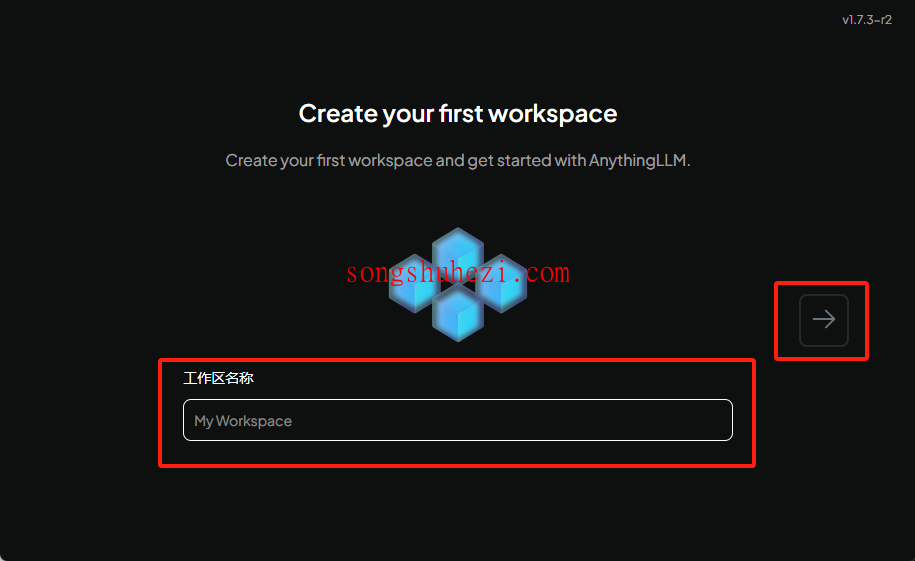

2. 创建工作区

打开AnythingLLM后,第一步就是创建一个工作区,工作区是你管理知识库的核心。

- 给你的工作区起个名字,比如“本地知识库”。

- 点击确认,工作区就创建好了。

这一过程非常简单,完全不需要复杂的设置。

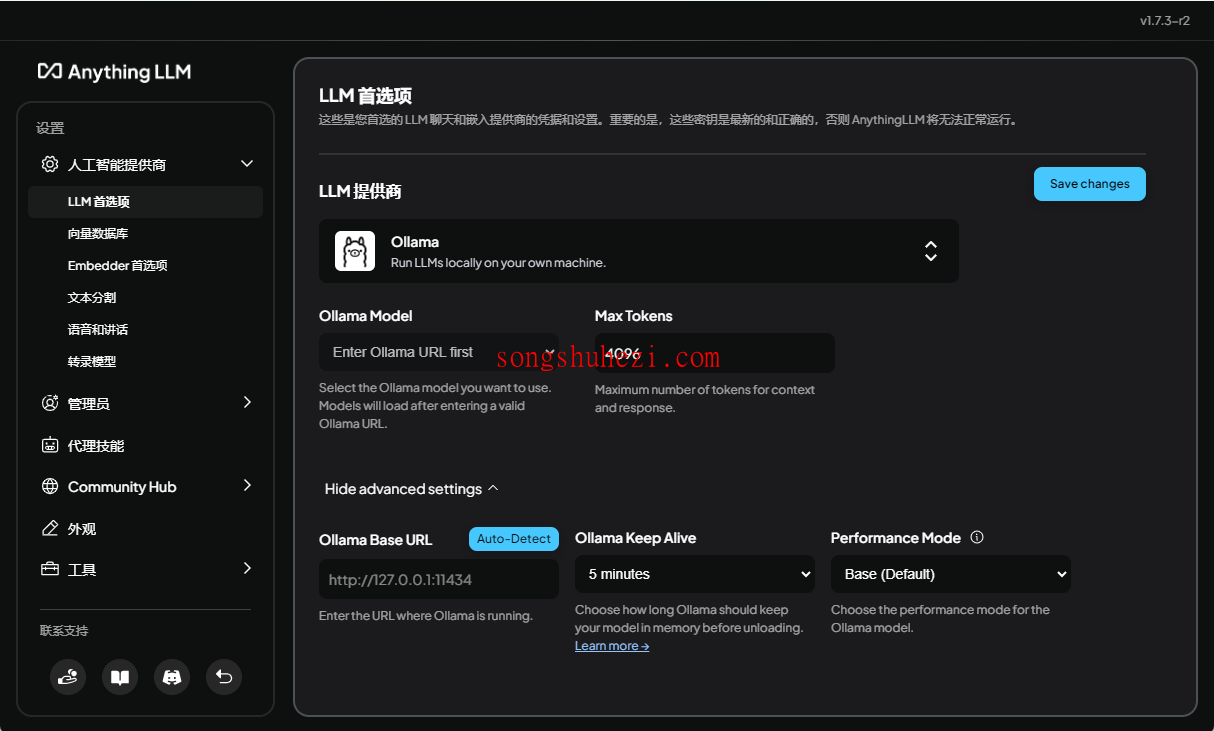

3. 配置模型

工作区创建好后,接下来的任务是将DeepSeeK和AnythingLLM连接起来,使其能够完成对话任务。

在左下角点击“扳手”图标,进入设置页面。

在“LLM首选项”中,选择Ollama作为对话模型。因为我们前面本地部署就是用的Ollama。

配置DeepSeeK的IP地址。如果是本地运行的DeepSeeK实例,输入

http://127.0.0.1:11434,记得加上http://。

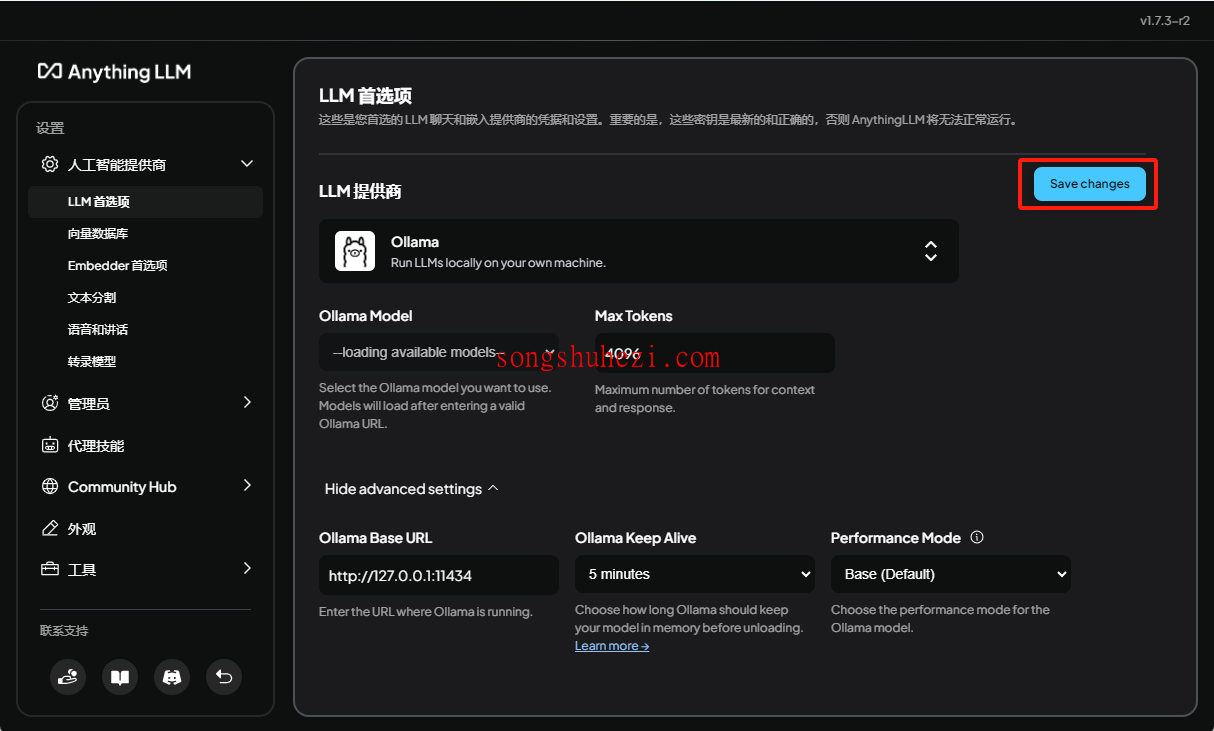

保存设置后,返回工作区页面,这里再修改一下工作区的模型配置。

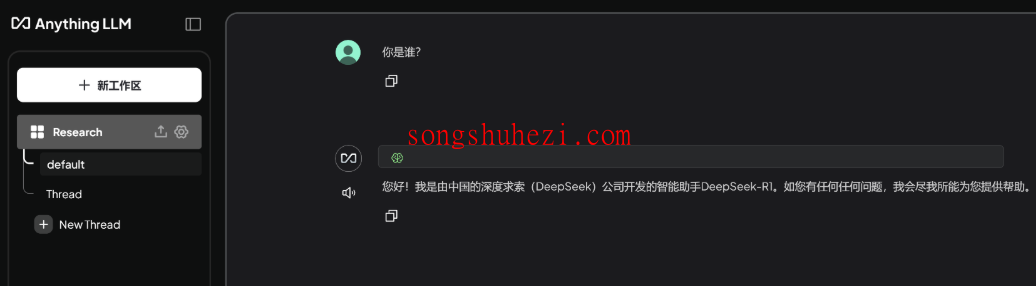

然后就可以看到对应IP下的所有本地模型,配置完成后就可以开始对话了。

4. 搭建知识库

接下来,我们就可以开始搭建自己的知识库了,详细教程可以看这篇:【DeepSeeK+AnythingLLM搭建本地知识库】

相关资源获取

为了大家方便,本教程所有用到的软件资源我都统一整理到网盘中了,大家需要的自行下载就好。

网盘链接:https://pan.quark.cn/s/4e3a3843a943

最后

从安装到配置再到实际使用,整个过程其实并不复杂。安装软件时需要注意网络环境,配置模型时需要确保IP地址和端口号正确。完成这些步骤后,你就可以通过AnythingLLM轻松实现本地AI模型的调用和交互,无需依赖外部服务器。对于需要经常处理本地数据或注重隐私的用户来说,这无疑是一个非常实用的解决方案。