Windows系统和Mac系统如何安装DeepSeek本地模型(Ollama+DeepSeek+ChatBox)

大家有没有遇到过这种情况?想用AI模型的时候,网页版总是提示“服务器繁忙,请稍后再试”,搞得人特别抓狂。如果你也有这样的烦恼,那我今天要分享的这个教程一定能帮到你。

我们要聊的是如何在本地部署DeepSeek,并且实现它的高效运行。教程虽然有点长,但步骤清晰,大家跟着做就能搞定,而且并不复杂哦!

本教程以Windows系统的环境为准,但原理是一样的。

第一步:安装Ollama

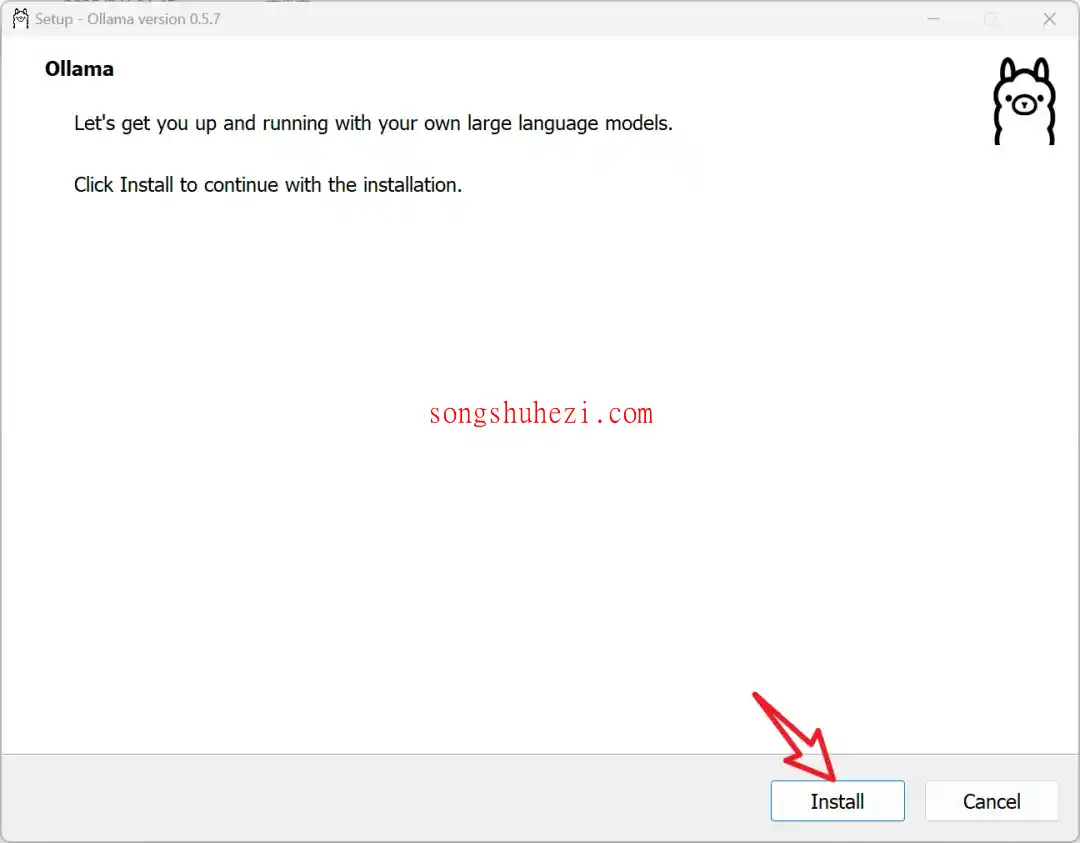

要想运行DeepSeek,我们需要先安装一个叫Ollama的工具。它是支持大模型本地调用的核心工具,DeepSeek的运行就是基于它的。

安装过程是全英文的,但别担心,操作很简单。只需要点击【Install】,然后一路“下一步”就行。

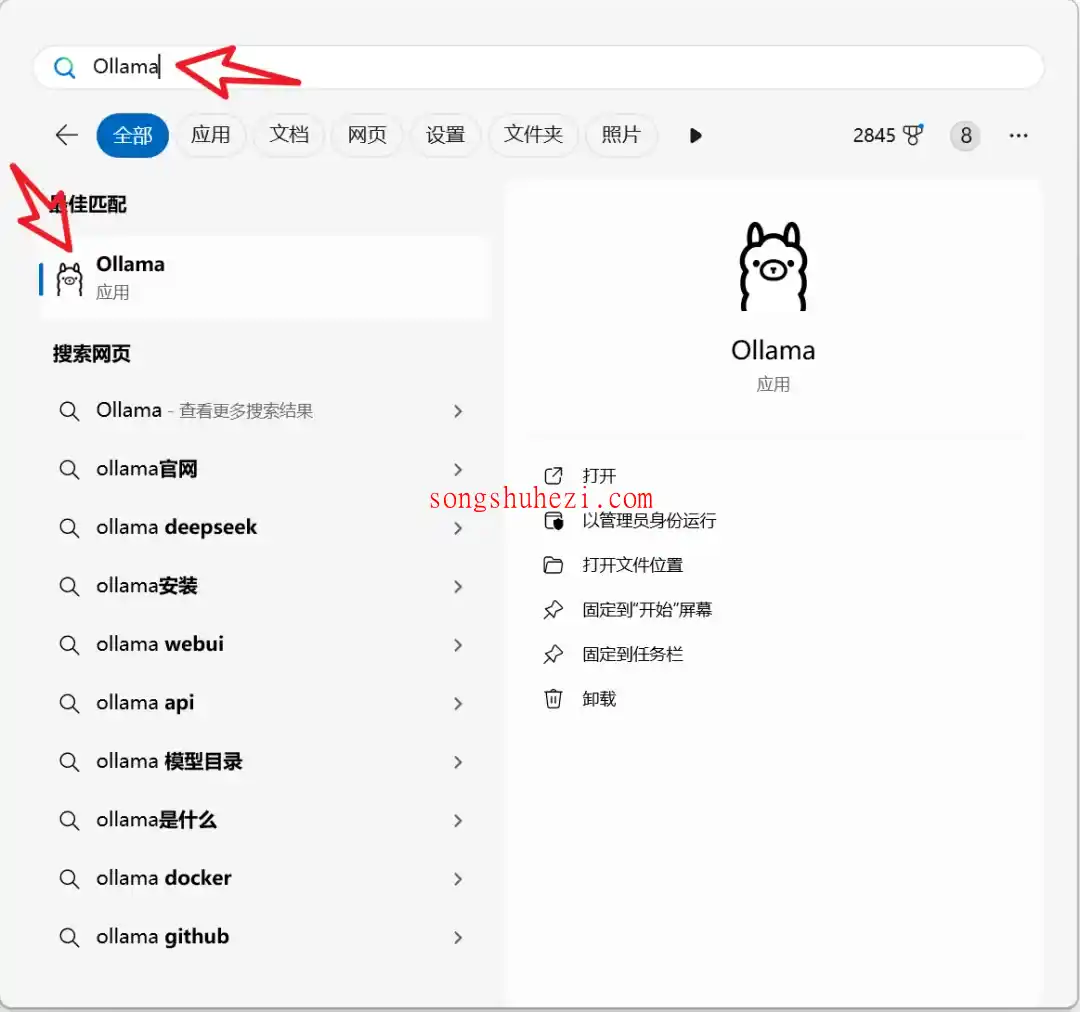

安装完成后,在电脑的开始菜单中搜索“Ollama”,点击软件图标就能启动啦。

第二步:安装DeepSeek模型

Ollama装好后,我们就可以安装DeepSeek模型了。

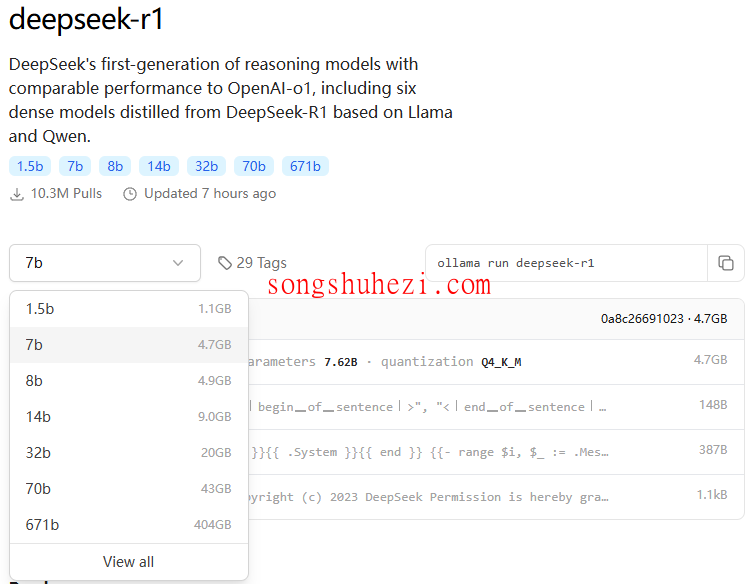

打开DeepSeek模型页面,你会看到几个不同的模型版本:

- 1.5B:适合硬件配置较低的电脑,最低要求4GB内存+核显。

- 7B:推荐版本,大部分电脑都能跑起来,要求8GB内存+4GB显存。

- 32B:高性能设备用,要求32GB内存+12GB显存。

这里强烈建议大家选择7B版本,性能和硬件要求比较平衡。选择后,复制对应的指令,比如“ollama run deepseek-r1:7b”。

如果配置不够的话,可以通过京东的国家补贴,购买mac mini m4 到手3k左右:https://u.jd.com/GGX8Uq3。

接下来,按下键盘上的“Win键+R”,输入“cmd”打开命令行窗口。

在窗口中输入刚才复制的指令,比如“ollama run deepseek-r1:7b”,然后回车。

这时,DeepSeek模型就会开始下载了。7B模型的体积相对较小,下载时间不会太久。等到命令行窗口中显示“success”字样,就说明模型安装成功了!

第三步:本地交互界面

如果你觉得直接用命令行操作有点麻烦,想要一个更友好的界面,那可以通过下面的几种方案完成本地交互界面。

方案一:通过ChatBox+Ollama实现本地AI交互界面

方案二:通过Cherry Studio+Ollama轻松实现本地AI交互界面

方案三:通过Page Assist+Ollama轻松实现本地AI交互界面

方案四:通过AnythingLLM+Ollama轻松实现本地AI交互界面

第四步:搭建本地知识库

如果你想搭建一个本地知识库问答系统,那么可以看看以下几种方案:

方案二:使用Cherry Studio搭建本地知识库问答系统

相关资源获取

为了大家方便,本教程所有用到的软件资源我都统一整理到网盘中了,大家需要的自行下载就好。

网盘链接:https://pan.quark.cn/s/4e3a3843a943

最后

到这里,DeepSeek的安装和配置就全部完成了!无论是用命令行、ChatBox客户端,还是浏览器插件,大家都可以根据自己的需求选择最适合的方式。

我的感觉是,DeepSeek确实挺强大的,尤其是本地运行,不用担心服务器繁忙的问题。虽然对硬件有一定要求,但只要选对模型版本,大部分电脑都能流畅运行。