如何在Windows系统上通过LMStudio部署DeepSeek-R1模型

你有没有想过在自己的电脑上运行AI模型,而不用依赖云端?今天就来聊聊如何在Windows系统上本地部署DeepSeek-R1模型,并通过LMStudio进行管理和使用。放心,教程会很详细,手把手教你搞定!

配置要求

在开始之前,先了解一下DeepSeek-R1的部署需求。根据模型的规模不同,硬件要求也会有所差异。以下是官方提供的配置建议表:

简单来说,DeepSeek-R1的模型规模从1.5B到671B不等,适用场景从个人学习到企业级服务都有覆盖。这里需要注意的是,1.5B、7B、8B等模型是通过蒸馏技术生成的轻量化版本,而671B才是基础模型。

硬件和软件环境

为了让更多人能轻松上手,本次教程采用了相对亲民的硬件配置:

- 操作系统:Windows 11

- CPU:i7-11800H

- 内存:16GB

- GPU:RTX 3050 Ti(4GB显存)

虽然这套配置无法运行超大规模模型,但用来部署8B这样的中小型模型完全没问题。

步骤一:安装LM Studio

LMStudio是一个非常方便的本地模型管理工具,支持下载、安装和运行各种本地LLM(大语言模型)。以下是安装步骤:

1、安装软件:

下载网盘中的LM Studio后,按照提示安装。

整个过程非常简单,一路“下一步”即可。

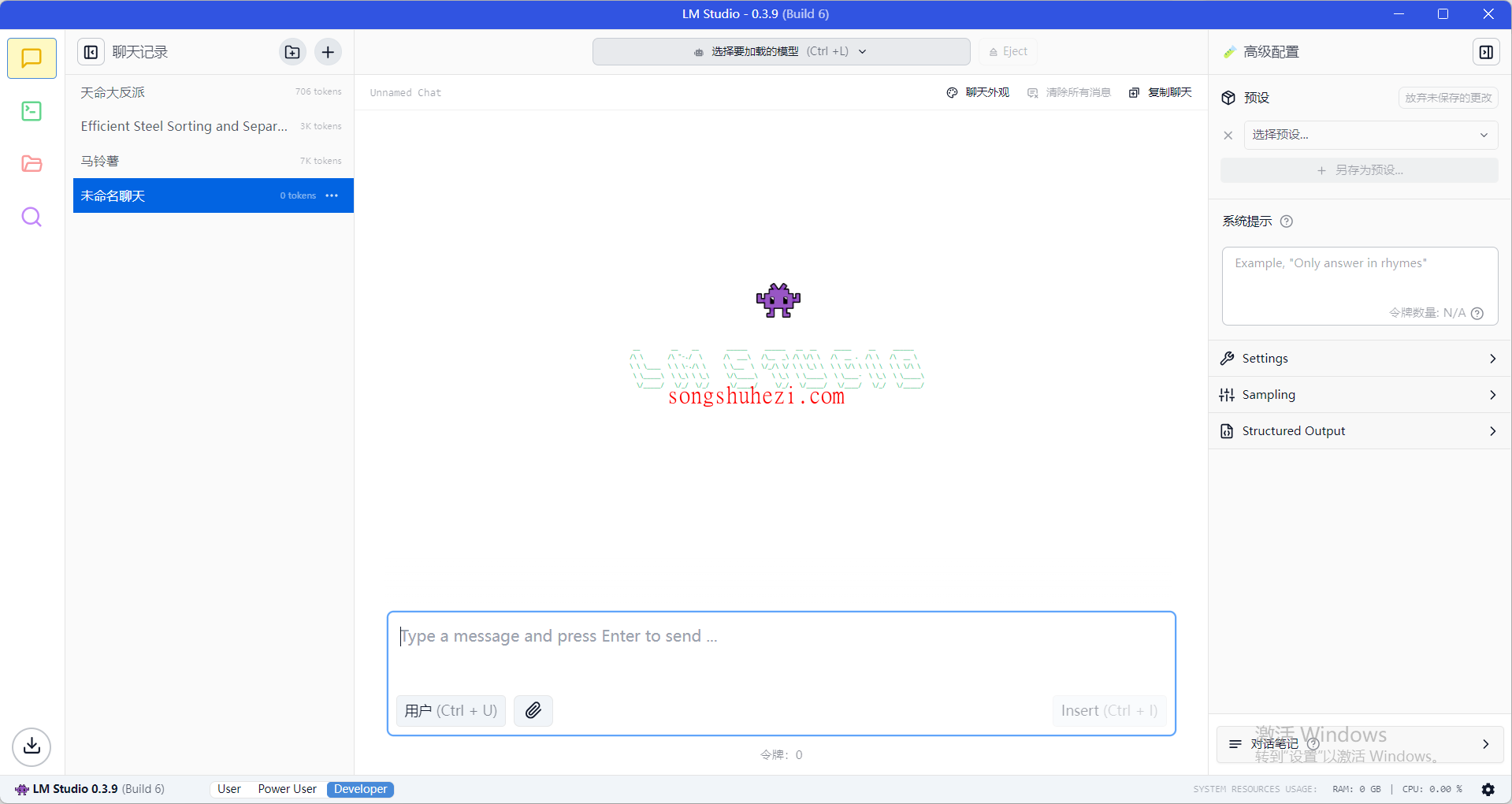

2、启动软件:

安装完成后,启动LM Studio,你会看到一个简洁的界面,左侧是模型管理区域,右侧是交互界面。

步骤二:安装DeepSeek-R1 8B模型

接下来,我们将在LM Studio中安装DeepSeek-R1的8B模型。以下是详细步骤:

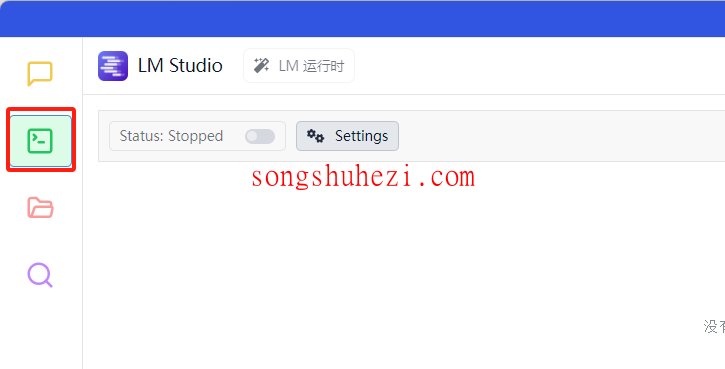

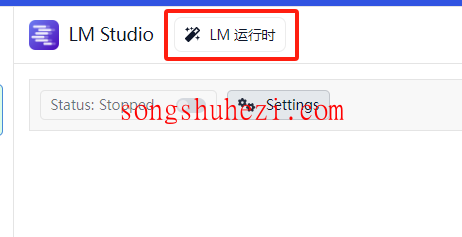

进入开发者模式

打开LM Studio,点击左下角的“App Setting”,进入开发者模式。这一步是为了解锁更多高级功能。

配置代理:

在“App Setting”中找到“代理选项”,配置一个可以访问外网的代理。你可以选择直接访问Hugging Face官网,或者使用镜像站点https://hf-mirror.com。

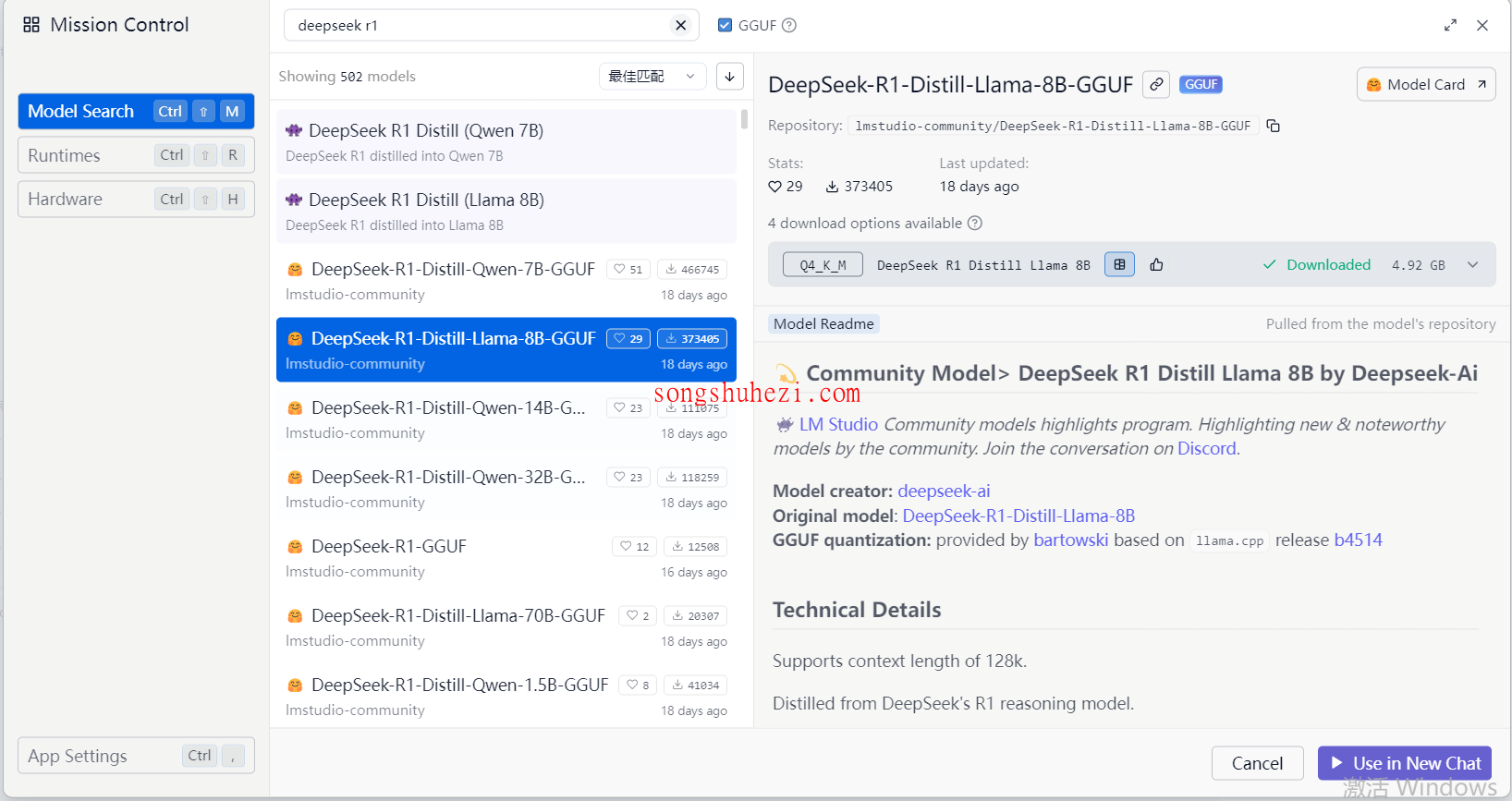

搜索模型:

回到主界面,点击左上角的“Model Search”,在搜索框中输入“DeepSeek-R1-Distill-Llama-8B-GGUF”。找到模型后,点击安装。

等待下载完成:

8B模型的大小大约是4.5GB,下载和安装需要一定时间,具体取决于你的网络速度。

步骤三:使用DeepSeek-R1 8B模型

模型安装完成后,就可以开始使用了!以下是几个关键的使用技巧:

选择模型:

在主界面的模型列表中,选择刚刚安装好的“DeepSeek-R1-Distill-Llama-8B-GGUF”。

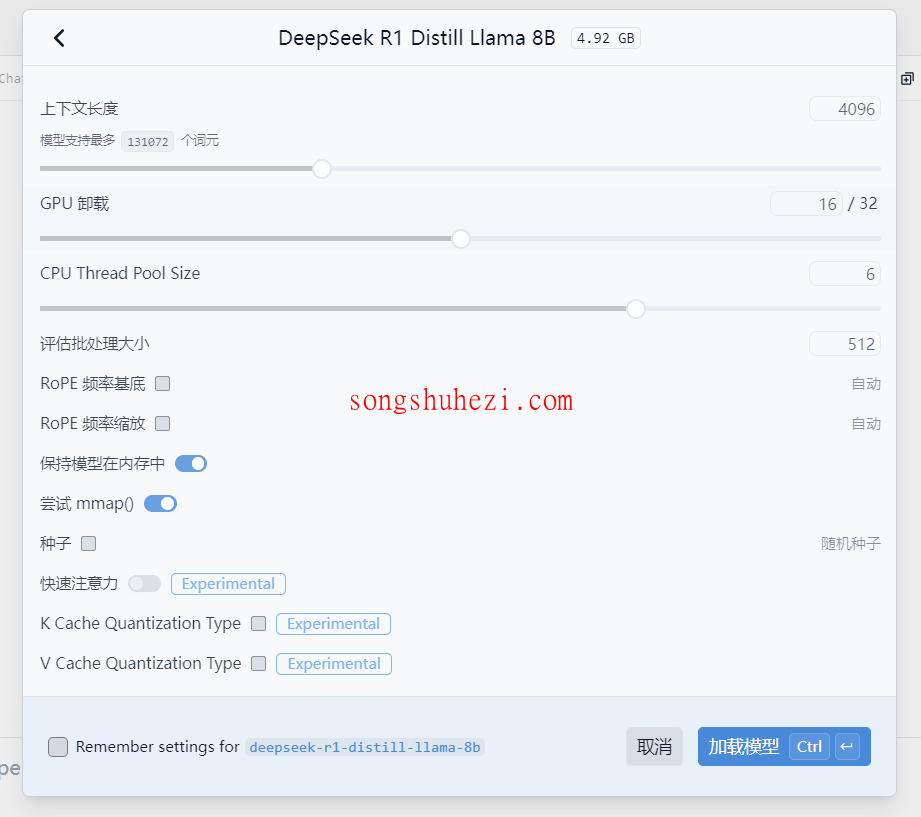

配置模型参数:

在模型配置界面,根据你的硬件性能调整参数。例如,如果显存较低,可以适当降低batch size。

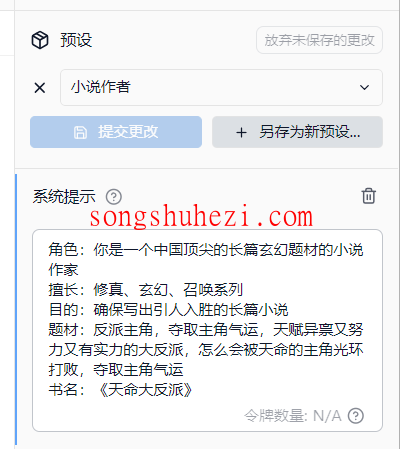

设置提示词:

在右侧的提示词输入框中,设置一个明确的任务描述。比如,如果你想让模型生成一篇文章,可以输入“请写一篇关于人工智能发展的科普文章”。

开始交互:

点击“运行”按钮,DeepSeek-R1会根据提示词生成内容。你可以根据需要调整提示词,优化输出结果。

额外技巧

如果你对模型的运行速度或输出质量不满意,可以尝试以下方法:

- 调整资源分配:

在LM Studio的设置中,可以手动分配更多系统资源给模型运行。 - 精简界面:

如果觉得界面信息过多,可以切换到简洁模式,隐藏不必要的功能。 - 书签管理:

LM Studio支持书签功能,可以快速切换不同的模型和任务。

相关资源获取

为了大家方便,本教程所有用到的软件资源我都统一整理到网盘中了,大家需要的自行下载就好。

网盘链接:https://pan.quark.cn/s/4e3a3843a943

我的感觉是,这套流程虽然看起来步骤不少,但实际操作起来并不复杂。尤其是LM Studio的界面设计非常友好,即使是新手也能快速上手。如果你的硬件配置允许,运行DeepSeek-R1的8B模型完全没问题。