Mac系统安装DeepSeek-R1本地模型(Ollama+Docker+Open WebUI)

说到在本地运行 AI 模型,很多人可能会觉得有点复杂,其实只要按照步骤来操作,整个过程还是挺简单的。今天就来聊聊如何在 Mac 上安装并运行 DeepSeek-R1 模型,同时通过 Open-WebUI 提供 Web 端访问。这一整套流程下来,不仅能让你体验到本地运行 AI 模型的乐趣,还能学到不少东西。

第一步:下载 OLLMA

在安装 DeepSeek-R1 之前,我们需要先安装 OLLMA。打开上面的链接,下载适合 macOS 的版本。下载完成后,按照提示安装就行,这里没啥复杂的操作。

第二步:下载 Llama3 模型

OLLMA 安装好后,我们需要下载 Llama3 模型的权重文件。这个模型有两个版本:8B 和 70B,分别是 4.7GB 和 39GB。一般日常使用的话,8B 就够用了,除非你有更高的需求或者想尝试更大的模型。

如果配置不够的话,可以通过京东的国家补贴,购买mac mini m4 到手3k左右:https://u.jd.com/GGX8Uq3。

打开 Mac 的终端(快捷键是 Command + Space,然后输入 Terminal)。

在终端中输入以下命令:

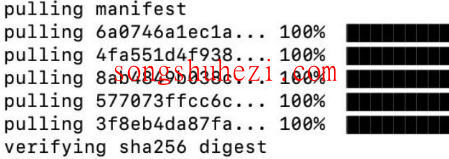

ollama pull llama3这条命令会开始下载模型,速度取决于网络情况,耐心等一会儿就好。

第三步:安装 Docker 和 Open WebUI

如果你觉得在终端里交互不够直观,可以安装 Open-WebUI,它提供了一个用户友好的 Web 前端,让你可以通过浏览器访问和使用 DeepSeek-R1。

所以我们接下来就来安装这两个工具。

3.1 安装 Docker

如果你的 Mac 上还没有安装 Docker,可以在网盘下载适配 macOS 的版本。

安装过程很简单,下载后双击安装包,根据提示一路“下一步”就行。安装完成后,记得注册一个 Docker 账号并登录。

3.2 安装 Open WebUI

打开终端,输入以下命令来安装 Open WebUI:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main这条命令会拉取最新的 Open WebUI 镜像,并将其映射到主机的 3000 端口,同时设置了持久化存储路径和自动重启策略。

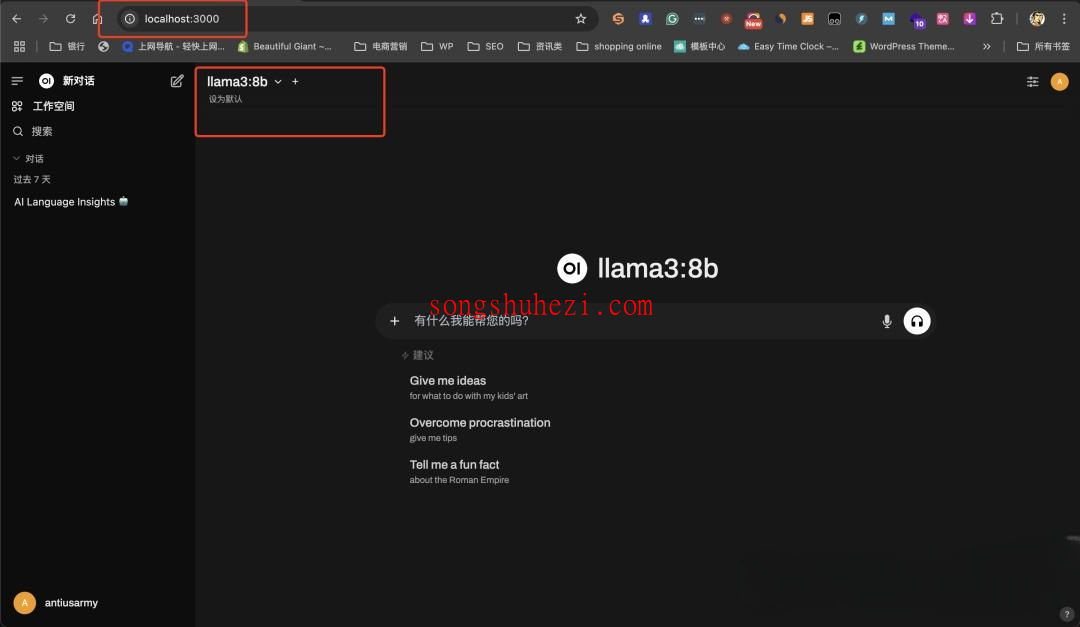

安装完成后,打开浏览器,访问

http://localhost:3000,首次访问时建议创建一个管理员账户。接下来,你就可以根据需求选择相应的模型了。

第四步:安装 DeepSeek R1

终于到了主角登场的环节!我们现在来安装 DeepSeek R1。

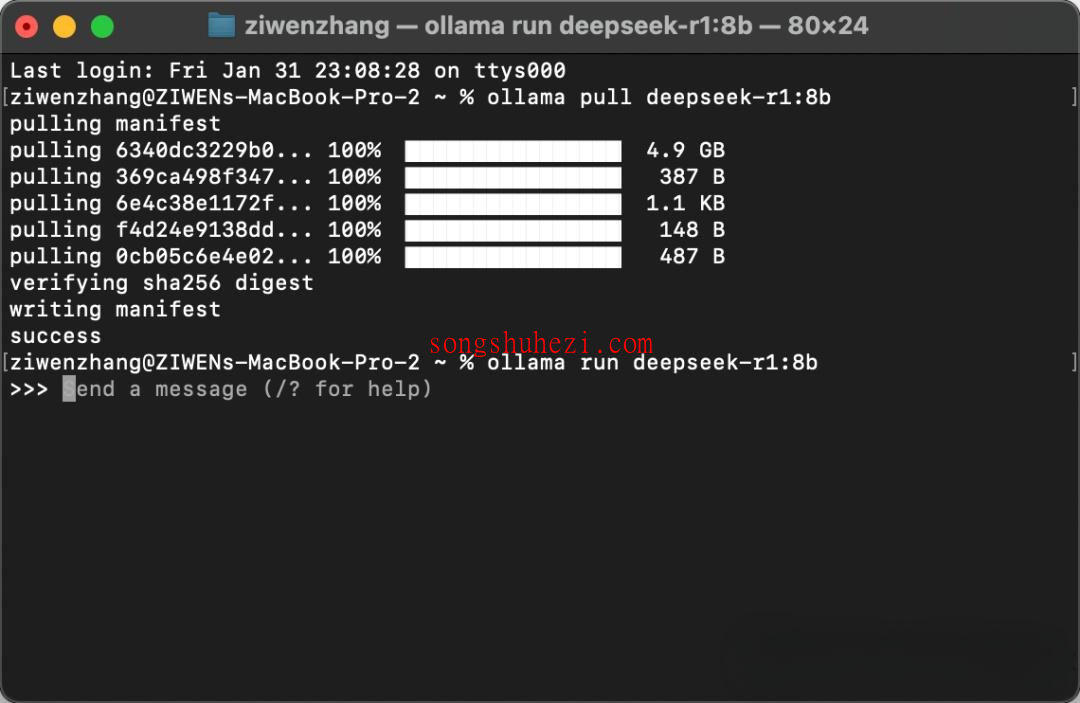

4.1 下载 DeepSeek 模型

打开终端,输入以下命令来下载 DeepSeek R1 的 8B 模型:

ollama pull deepseek-r1:8b

同样,下载时间取决于模型大小和网络速度,耐心等待。

4.2 运行 DeepSeek 模型

模型下载完成后,在终端中运行以下命令来启动 DeepSeek 模型:

ollama run deepseek-r1:8b

运行成功后,DeepSeek 模型就可以正常使用了。

第五步:在 Open WebUI 中配置 DeepSeek

现在我们需要将 DeepSeek 模型配置到 Open WebUI 中,具体操作如下:

- 打开 Open WebUI 应用程序。

- 在设置中找到模型提供方的选项,选择 “OLLMA”。

- 在模型列表中,选择刚刚安装的 DeepSeek 模型(如 deepseek-r1:8b)。

完成以上步骤后,你就可以在 Open WebUI 中直接调用 DeepSeek 模型进行使用了。

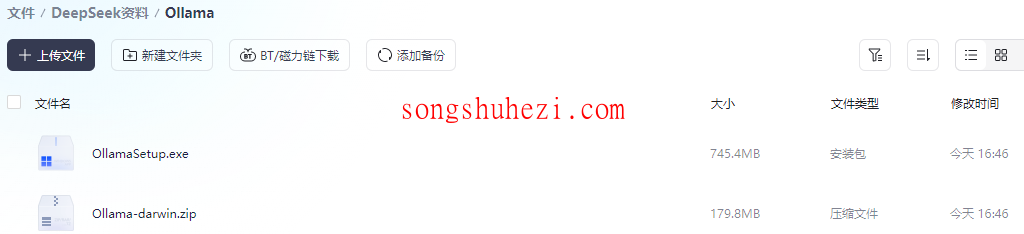

相关资源获取

为了大家方便,本教程所有用到的软件资源我都统一整理到网盘中了,大家需要的自行下载就好。

网盘链接:https://pan.quark.cn/s/4e3a3843a943

结语

整个安装流程下来,其实并没有想象中那么复杂,主要就是按部就班地完成每一步。如果你是新手,可能会对一些命令行操作有点陌生,但只要耐心点,跟着教程来,肯定能搞定。而且 DeepSeek-R1 的功能确实挺强大,跑起来后体验也很流畅,值得一试!