如何通过Mac mini M4使用DeepSeek?

你有没有想过,用一台小巧的Mac mini M4,就能搭建一个强大的AI工作站?尤其是运行DeepSeek R1这种大模型,既能节省成本,又能保障数据安全。今天就来聊聊如何在Mac mini上本地部署DeepSeek R1大模型,简单三步搞定,轻松开启智能办公。

为什么选择Mac mini M4?

Mac mini M4不仅性能强大,还兼具紧凑设计和低功耗。它的32GB内存和M4芯片,足以胜任大多数AI模型的推理任务,尤其是DeepSeek R1的14B和32B模型。这种配置对于小企业或个人开发者来说,性价比非常高。

而且现在通过京东的国家补贴,购买mac mini m4 到手3k左右:https://u.jd.com/GGX8Uq3。

部署前的准备工作

在开始之前,你需要确保以下几点:

- 硬件配置:建议至少32GB内存的Mac mini M4。如果你预算充足,64GB内存的版本更佳。

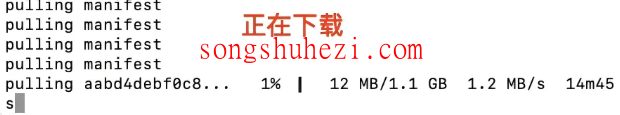

- 存储空间:14B模型需要约20GB,32B模型则需要60GB以上,建议外接SSD存储。

- 网络环境:虽然是本地部署,但初始下载模型和后续更新需要稳定的网络支持。

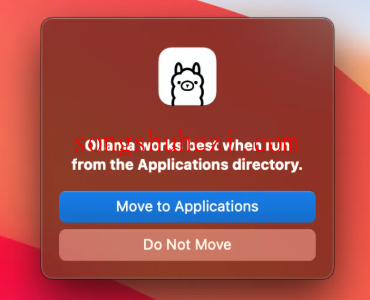

- 安装工具:我们需要用到Ollama工具,它是运行DeepSeek模型的关键。

三步搞定DeepSeek R1部署

接下来,我们分三步完成部署,步骤简单易懂,不需要高深的技术背景。

如果你还没有通过ollama把deepseek下载到本地,那你可以先看看这篇:【如何安装DeepSeek本地模型】

如果你已经下载到本地了,那我们继续往下看。

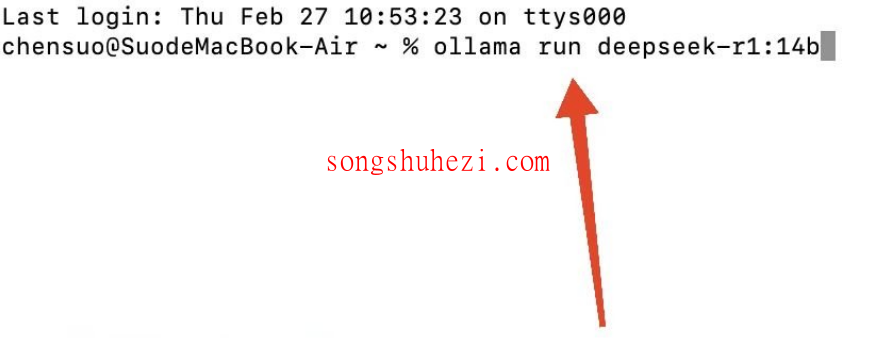

第一步:运行DeepSeek模型

模型下载完成后,就可以启动模型进行推理任务了。

以下是运行不同模型的命令:

运行14B模型:

bashollama run deepseek-r1:14b运行32B模型:

bashollama run deepseek-r1:32b

如果需要在局域网内远程调用,可以运行以下命令:

bash

ollama serve

然后在其他设备上通过IP地址访问。

部署中的优化建议

为了让你的Mac mini在运行DeepSeek模型时表现更优异,这里有一些优化小技巧:

释放内存:运行大模型时,内存占用会接近设备上限。可以通过以下命令查看并释放内存:

bashps aux | grep "ollama"找到相关进程后,手动终止不必要的任务。

外接存储:如果模型文件占用了太多内置存储,可以将模型文件存放在外接SSD上。Ollama支持自定义模型路径。

调整资源分配:在Ollama的配置文件中,可以手动调整模型加载的资源分配,确保推理速度和系统稳定性。

后台运行:通过以下命令将模型运行设置为后台模式,避免终端中断:

bashollama run deepseek-r1:32b & disown

场景推荐

在实际使用中,DeepSeek R1的14B模型在Mac mini M4上表现非常流畅,生成速度可达10-12 tokens/s,适合日常问答和简单代码生成。而32B模型虽然更强大,但速度稍慢,适合需要复杂逻辑推理或长文本生成的场景。

如果你是开发者,可以用它辅助编写代码;如果是小企业主,可以用它生成技术文档或处理客户咨询。总之,这是一款非常实用的大模型。

最后

感觉嘛,用Mac mini M4搭建一个AI工作站,确实是个不错的选择。既省钱又省心,尤其是本地部署,数据安全性更高。操作也不复杂,哪怕是对技术不太熟悉的小伙伴,也能轻松上手。如果你也有类似的需求,不妨试试这个方案,说不定会有意想不到的收获!