通过Cherry Studio+Ollama轻松实现本地AI交互界面

如果你需要一个更方便的工具来管理和使用本地AI模型,那Cherry Studio客户端绝对是一个不错的选择。它不仅界面简洁,而且操作起来特别直观,适合各种用户群体。接下来,我就教大家如何安装和配置Cherry Studio客户端,让它和Ollama的模型完美配合。

安装Ollama

前面我写过各个系统的安装教程,大家可以看一看:

然后到Ollama的模型超市【官方链接:https://ollama.com/search】下载自己想要的模型。

比如:

如果你想要接入DeepSeek,可以看看这篇教程:

【如何通过Ollama+ChatBox安装DeepSeek本地模型】

安装Cherry Studio客户端

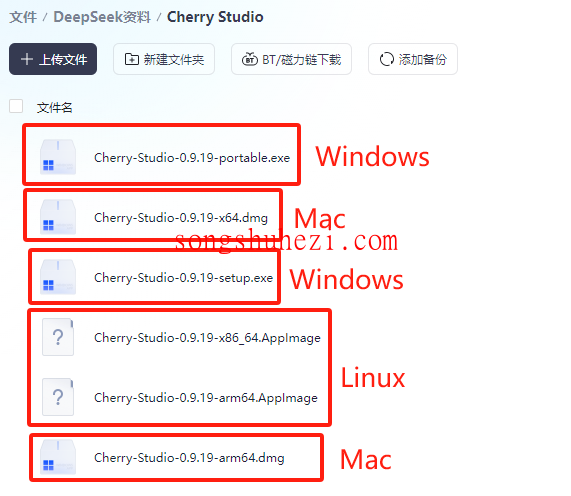

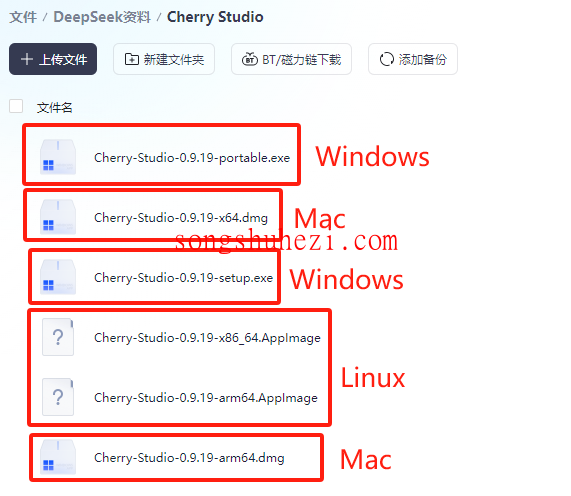

首先,我们来搞定安装部分。在我提供的链接里,找到对应Cherry Studio客户端的安装包。

直接双击运行,然后按照提示一步步操作,基本上就是“下一步”“下一步”,几分钟内就能安装完成。

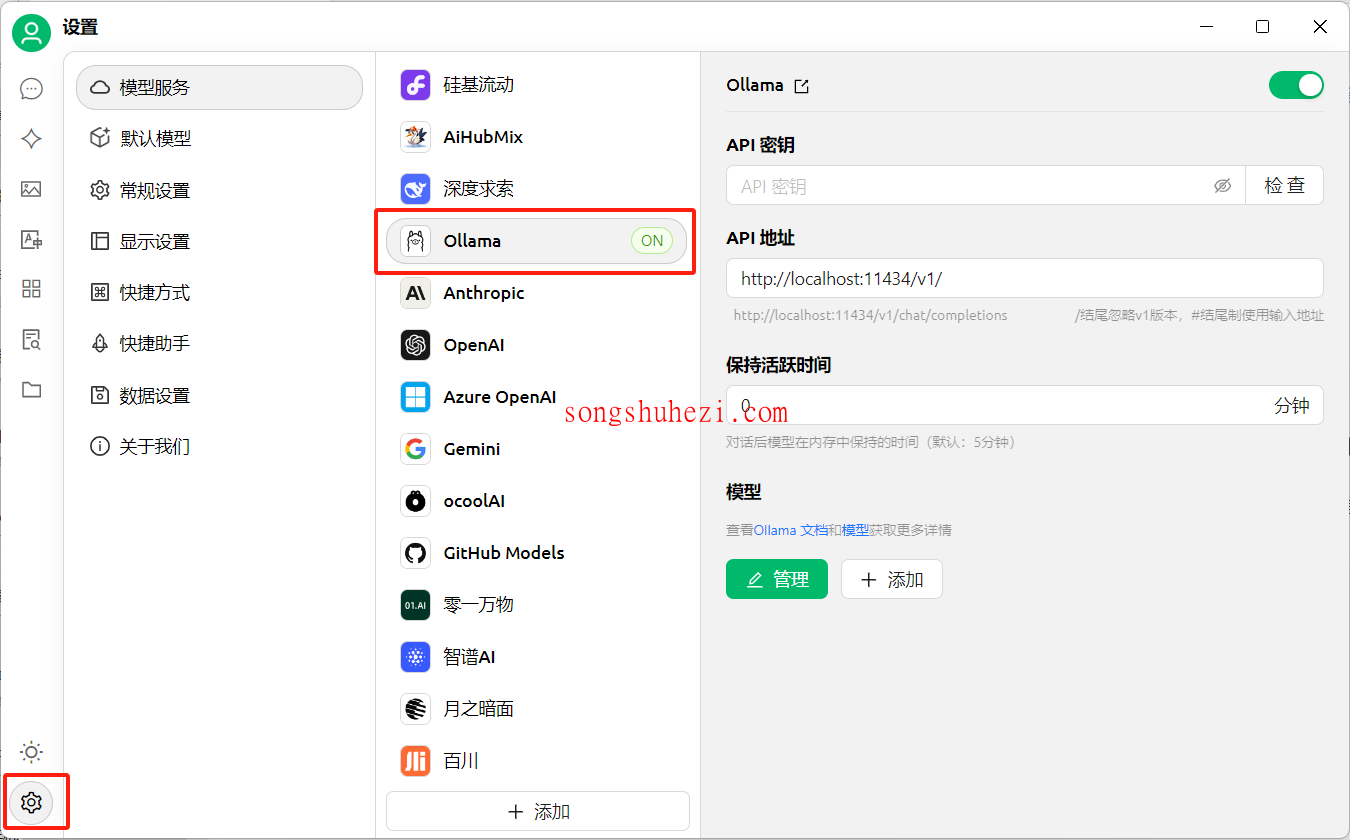

安装成功后,打开Cherry Studio客户端。界面很清爽,左下角有一个“设置”按钮,这就是我们接下来要用到的地方。

配置Cherry Studio与Ollama模型

进入设置页面后,我们需要进行一些简单的配置,让Cherry Studio能够正确连接到你的本地AI模型。以下是具体步骤:

模型选择:在设置界面中,你会看到一个模型选择列表。这里需要注意的是,除了本地的Ollama模型,其他选项都不要勾选。这样可以确保Cherry Studio只连接到你的本地模型,避免不必要的资源浪费或者网络请求。

添加模型:接下来,点击底部的“添加”按钮。一个新的窗口会弹出来,在这里你可以添加你的本地模型。如果你之前在Ollama中配置了多个模型,这里会显示这些模型的列表,你可以选择需要的那个。

保存设置:所有配置完成后,记得点击保存按钮。这样,Cherry Studio就会自动加载你选择的模型。

开始使用Cherry Studio

配置完成后,你就可以直接使用Cherry Studio了。比如,你可以在界面里输入问题,或者调用模型进行任务处理。Cherry Studio会根据你选择的模型,快速返回结果。整个过程简单又高效,非常适合需要频繁调用AI模型的小伙伴。

小贴士

- 如果在添加模型时没有看到你想要的模型,可以检查一下Ollama的配置是否正确,或者重新加载模型列表。

- Cherry Studio支持多模型管理,你可以根据需求自由切换,非常灵活。

- 客户端的界面还可以自定义,比如调整主题颜色、字体大小等,让使用体验更贴心。

搭建知识库

接下来,我们就可以开始搭建自己的知识库了,详细教程可以看这篇:【使用Cherry Studio搭建本地知识库问答系统】

相关资源获取

为了大家方便,本教程所有用到的软件资源我都统一整理到网盘中了,大家需要的自行下载就好。

网盘链接:https://pan.quark.cn/s/4e3a3843a943

最后

Cherry Studio的确是一个非常实用的工具,尤其是对于那些需要管理多个本地AI模型的用户来说,简直就是神器。它的操作逻辑简单明了,即使是技术小白也能快速上手。而且,和Ollama模型的配合也很顺畅,几乎没有什么卡顿或者延迟。如果你对本地AI模型感兴趣,强烈推荐试试Cherry Studio客户端!