在Windows系统上安装与配置Ollama

Ollama是一款开源工具,专为本地运行和管理大语言模型设计,支持多平台、多模型,操作简单,优化资源使用,保护用户隐私。

如果你想在Windows系统上试用Ollama并运行大语言模型,那么这篇教程绝对是你的不二选择!从下载安装到环境配置,再到验证运行,这里会手把手教你如何轻松搞定。

一、完成下载安装

1、这里我已经帮大家把安装包整理到网盘中了,大家点击下面的链接进行下载就行了。

网盘链接:https://pan.quark.cn/s/7df4a1823eb5

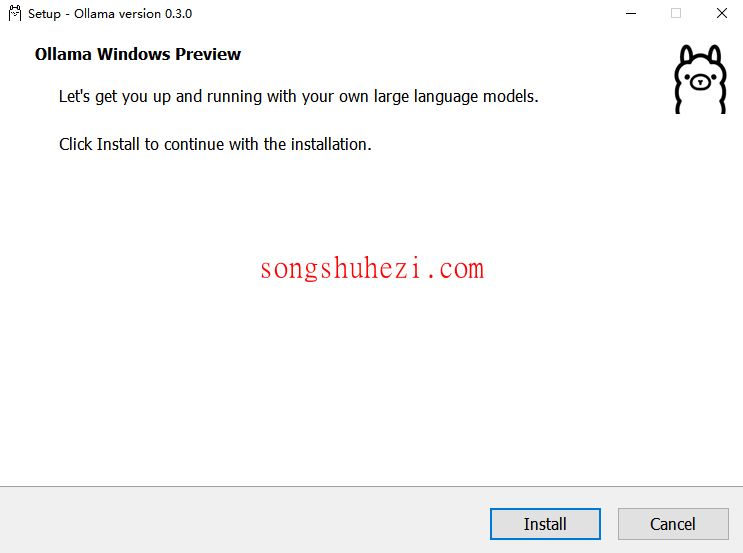

2、点击下载OllamaSetup.exe文件,完成后双击运行安装程序。弹出安装界面后,直接点击Install,等待安装完成。

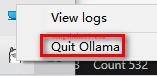

3、安装完成后,Ollama会自动启动。你可以在任务栏找到Ollama图标,右键点击可以选择退出(Quit Ollama)或查看日志(logs)。

二、环境变量配置

安装完成后,建议根据实际需求设置环境变量,优化使用体验。以下是一些常用的环境变量及其配置建议:

| 参数 | 描述与建议 |

|---|---|

| OLLAMA_MODELS | 模型存储路径,默认为C:\Users\%username%\.ollama\models,建议更改到其他分区(如E:\ollama\models)。 |

| OLLAMA_HOST | 服务监听地址,默认是127.0.0.1,如果需要局域网访问,改为0.0.0.0。 |

| OLLAMA_PORT | 服务监听端口,默认是11434,如有冲突,可更改为其他端口(如8080)。 |

| OLLAMA_ORIGINS | HTTP客户端请求来源,默认值为*,表示不限制来源。 |

| OLLAMA_KEEP_ALIVE | 模型在内存中的存活时间,默认为5分钟。建议设置为24h,以提升访问速度。 |

| OLLAMA_NUM_PARALLEL | 同时处理的请求数量,默认是1,可根据需求调整。 |

| OLLAMA_MAX_QUEUE | 请求队列长度,默认是512,超过此值的请求会被丢弃。 |

| OLLAMA_DEBUG | 调试模式,设置为1可输出详细日志,便于排查问题。 |

| OLLAMA_MAX_LOADED_MODELS | 内存中同时加载的模型数量,默认为1,可根据需求增加。 |

更改模型存储路径

默认情况下,模型会存储在C盘。为了节省空间,建议将路径更改到其他分区:

1、添加OLLAMA_MODELS环境变量,例如设置为E:\ollama\models。

2、设置完成后,重启Ollama或PowerShell即可生效。

三、运行Ollama

1、打开命令行,输入以下命令启动Ollama服务:

ollama serve

2、如果出现端口冲突错误提示(如Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address...),按照以下步骤解决:

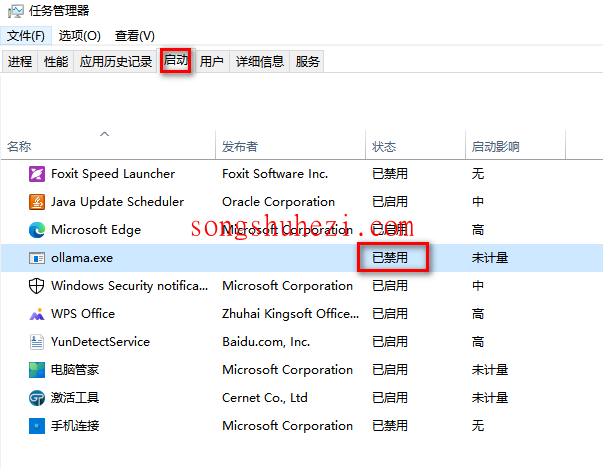

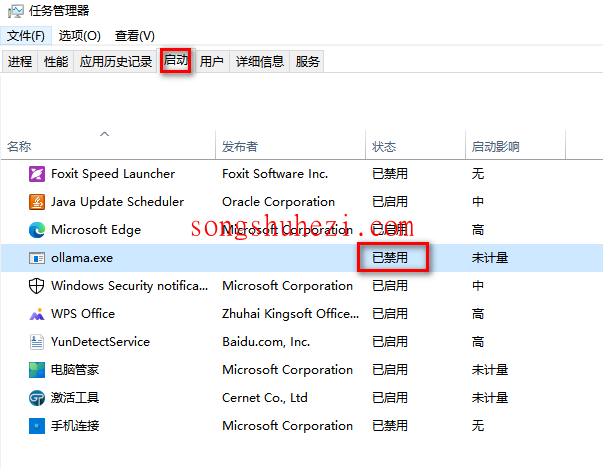

使用快捷键

Win+X打开任务管理器,找到启动选项卡,禁用Ollama的开机自启。

在任务管理器的

进程选项卡中,结束Ollama的运行任务。再次运行

ollama serve命令。

3、验证服务是否成功启动:

- 打开命令行,输入以下命令查看端口占用情况:

netstat -aon|findstr 11434 - 如果显示

LISTENING状态,说明Ollama服务已成功启动。

4、查看占用端口的进程信息:

tasklist|findstr "进程号"

如果输出中显示ollama.exe,说明Ollama已正常运行。

四、验证安装成功

1、在终端输入以下命令查看帮助信息:

ollama -h

如果输出Ollama的命令列表和帮助信息,说明安装成功!

2、运行一个模型测试:

- 访问Ollama模型库,选择一个你感兴趣的模型。

- 输入以下命令运行模型:

ollama run llama3 - 等待模型下载完成后即可使用。下载速度取决于你的网络带宽。

3、使用Ctrl+D退出模型会话。

五、如何取消开机自启

如果你不希望Ollama开机自启,可以按照以下步骤操作:

1、打开任务管理器。

2、选择启动应用选项卡。

3、找到ollama.exe,右键点击,选择禁用。

整个安装与配置过程还是蛮简单的,Ollama在Windows系统上的表现也很流畅。特别是环境变量的灵活配置,让用户可以根据需求调整性能表现。如果你对本地运行大语言模型感兴趣,不妨试试Ollama!安装好后,赶紧体验一下吧!