在Linux系统上安装与配置Ollama

Ollama是一款开源工具,专为本地运行和管理大语言模型设计,支持多平台、多模型,操作简单,优化资源使用,保护用户隐私。

对于Linux用户来说,Ollama提供了一种便捷的方式来运行本地大语言模型。无论你是想快速安装,还是手动配置服务,本文都会一步步教你如何操作,同时还会介绍如何更新、查看日志以及卸载Ollama。

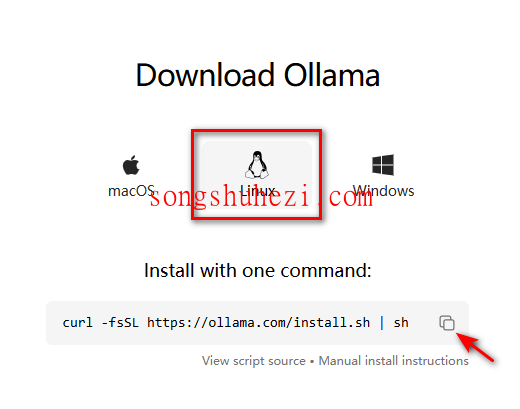

一、快速安装

打开终端,执行以下命令以快速安装Ollama:

curl -fsSL https://ollama.com/install.sh | sh这条命令会自动下载最新版本的Ollama并完成安装。

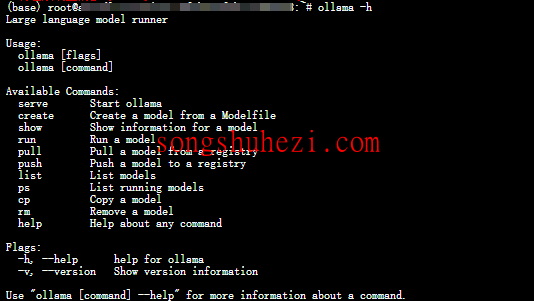

常用命令参考:

ollama serve:启动Ollama服务。ollama create:从模型文件创建模型。ollama show:显示模型信息。ollama run:运行模型。ollama pull:从注册表中拉取模型。ollama push:将模型推送到注册表。ollama list:列出所有模型。ollama cp:复制模型。ollama rm:删除模型。ollama help:获取命令帮助信息。

验证安装是否成功:

ollama -h如果终端输出Ollama的帮助信息,说明安装完成🎉。

启动并运行模型:

首先在后台启动Ollama服务:

ollama serve然后开启一个新终端,运行模型:

ollama run llama3模型会自动下载,下载速度取决于你的网络带宽。下载完成后即可开始使用。

使用

Ctrl+D退出对话。

二、手动安装

如果你更喜欢手动安装,以下是详细步骤:

这里我已经帮大家把安装包整理到网盘中了,大家点击下面的链接进行下载就行了。

网盘链接:https://pan.quark.cn/s/7df4a1823eb5

2.1 下载二进制文件

- 下载Ollama的二进制文件到

/usr/bin目录:sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama sudo chmod +x /usr/bin/ollama

2.2 添加为自启动服务

创建一个用户来运行Ollama:

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama创建服务文件:

在/etc/systemd/system/ollama.service路径下创建服务文件,内容如下:[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 [Install] WantedBy=default.target启动服务:

sudo systemctl daemon-reload sudo systemctl enable ollama sudo systemctl start ollama

2.3 验证服务运行状态

使用以下命令检查服务是否正常运行:

sudo systemctl status ollama

如果显示Active: active (running),说明服务启动成功。

三、更新Ollama

使用快速安装命令更新:

curl -fsSL https://ollama.com/install.sh | sh或者手动下载最新的二进制文件:

sudo curl -L https://ollama.com/download/ollama-linux-amd64 -o /usr/bin/ollama sudo chmod +x /usr/bin/ollama

四、安装特定版本

如果需要安装特定版本的Ollama,可以通过设置环境变量OLLAMA_VERSION来指定版本号。例如:

curl -fsSL https://ollama.com/install.sh | OLLAMA_VERSION=0.1.32 sh

五、查看日志

如果Ollama作为服务运行,可以通过以下命令查看日志:

journalctl -e -u ollama

这条命令会显示最新的日志信息,方便排查问题。

六、卸载Ollama

如果你不再需要使用Ollama,可以按照以下步骤卸载:

停止并禁用服务:

sudo systemctl stop ollama sudo systemctl disable ollama删除服务文件:

sudo rm /etc/systemd/system/ollama.service删除Ollama二进制文件:

sudo rm $(which ollama)删除下载的模型和用户:

sudo rm -r /usr/share/ollama sudo userdel ollama sudo groupdel ollama

在Linux系统上安装和配置Ollama其实并不复杂,特别是提供了快速安装脚本,几乎一条命令就能搞定。如果你对模型加载速度、服务稳定性有更高要求,可以选择手动安装并配置为自启动服务。总的来说,Ollama是一个灵活性很高的工具,非常适合需要本地运行大语言模型的用户。赶紧试试吧!