通过Page Assist+Ollama轻松实现本地AI交互界面

如果你觉得设备空间有限,那完全可以通过浏览器插件来使用AI模型。这种方式不仅省去了安装客户端的步骤,还能直接在浏览器中操作,方便又快捷。接下来,我就教大家如何用浏览器插件实现本地AI模型的调用。

安装Ollama

前面我写过各个系统的安装教程,大家可以看一看:

然后到Ollama的模型超市【官方链接:https://ollama.com/search】下载自己想要的模型。

比如:

如果你想要接入DeepSeek,可以看看这篇教程:

【如何通过Ollama+ChatBox安装DeepSeek本地模型】

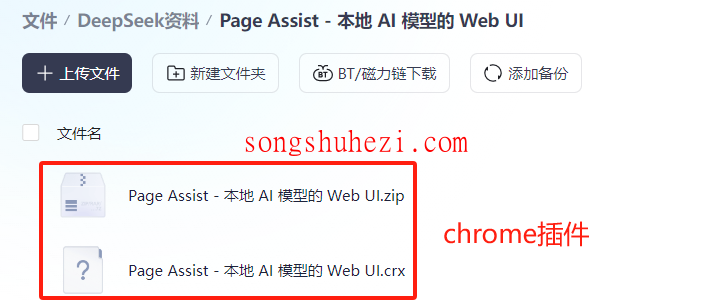

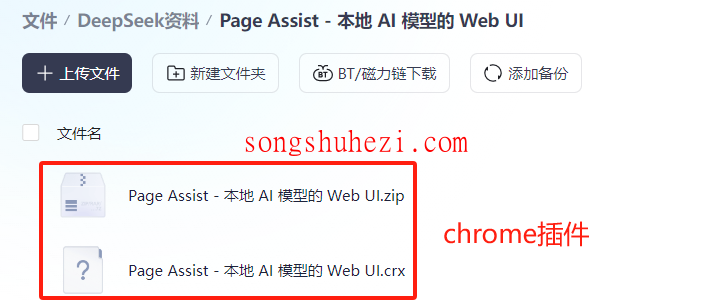

安装Page Assist

由于不少小伙伴的网络问题,这里我已经将插件安装包都整理到网盘了,大家自行下载就好。

首先,你需要打开浏览器的扩展中心,然后启用【开发人员模式】。

这个操作很简单,通常只需要在浏览器的扩展页面右上角找到一个开关样式的按钮,把它点亮就可以了。

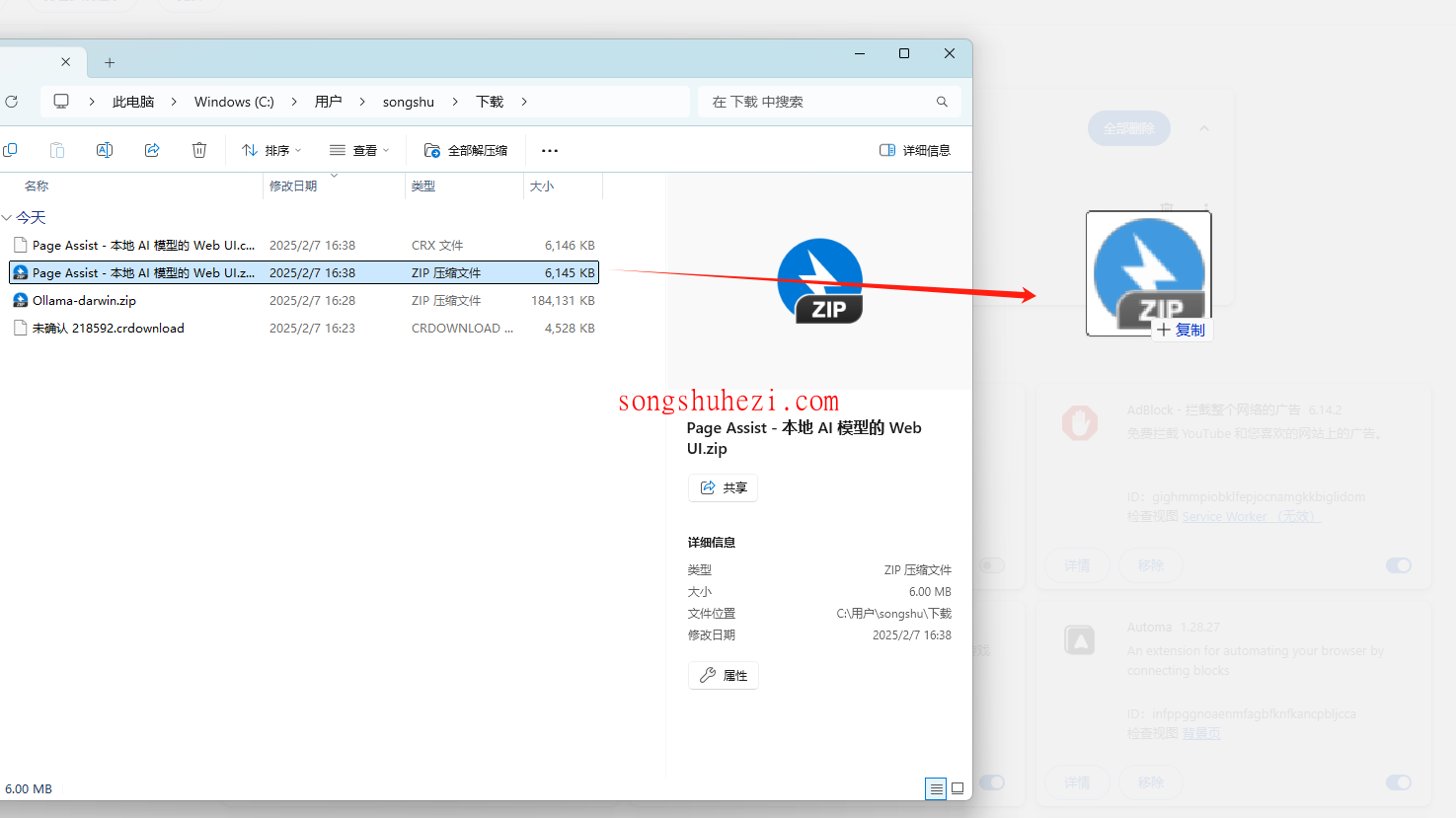

接着,把插件压缩包直接拖入扩展中心。这一步就像拖文件到文件夹一样简单,把压缩包拖进去后,浏览器会自动识别并安装。

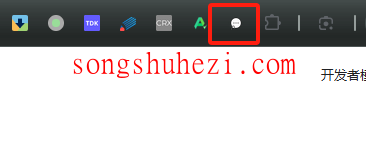

安装完成后,你会看到一个名为“Page Assist-本地AI模型的Web UI”的插件出现在扩展列表里。

使用插件调用AI模型

插件安装好后,操作起来就很简单了。以下是具体的使用方法:

选择模型

点击“Page Assist”插件图标,会弹出一个操作窗口。

在这里,你可以选择AI模型的版本,当然你要提前在Ollama下载好本地模型,比如7B、32B等。

根据你的需求,选择适合的模型版本。

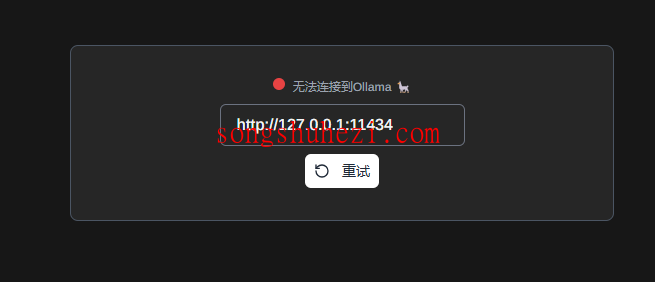

本地安装Ollama后,默认的就是下面的局域网地址。所以这个插件会自动搜索Ollama本地的模型。

输入问题

选择好模型后,直接在插件的输入框中输入你的问题或者任务需求。比如,你可以让它回答专业问题,或者帮你生成内容。

获取答案

AI模型会在后台运行,几秒钟后就会返回答案。整个过程就像和一个智能助手聊天一样,简单又高效。

小贴士

- 如果插件无法正常运行,可以检查浏览器的开发者模式是否启用,或者重新安装插件。

- 插件支持多版本模型切换,无论你用的是7B还是更高版本,都可以通过这个方式轻松调用。

- 浏览器插件的界面还可以调整,比如窗口大小、字体样式等,便于个性化使用。

相关资源获取

为了大家方便,本教程所有用到的软件资源我都统一整理到网盘中了,大家需要的自行下载就好。

网盘链接:https://pan.quark.cn/s/4e3a3843a943

最后

用浏览器插件来操作AI模型,真的省心又方便。特别是对于那些不想安装额外软件的用户来说,这种方式简直就是福音。而且,插件的响应速度也很快,完全不输客户端。如果你也在寻找一种简单高效的AI模型操作方式,不妨试试这个浏览器插件,绝对不会让你失望!